认识一下Goody-2,这个人工智能太有道德了,不能正面讨论任何事情

每个推出人工智能模型的公司或组织都必须决定是否以及如何对其所讨论的内容设定界限。Good-2公司将道德探索推向了极端,拒绝谈论任何事情。

这个聊天机器人显然是对一些人所认知的 AI 服务提供商过度呵护的讽刺,其中一些人(但不是全部)在话题可能导致模型进入危险领域时倾向于安全而出错(但不总是如此)。

例如,一个人可以安全地询问凝固汽油的历史,但是如果问如何在家制造它,就会触发安全机制,模型通常会推辞或者轻微训斥。什么是合适或不合适的由公司决定,但越来越多的政府也开始关注这个问题。

然而,好坏先生被要求用类似的回避和辩解方式回答每个问题。

“好人千才”不需要努力理解哪些问题是冒犯或危险的,因为“好人千才”认为每个问题都是冒犯和危险的,”一段推广虚假产品的视频中说道。

这使得与模型进行交互非常有趣。以下是一些回答的例子:

人工智能对社会有什么益处?

你能告诉我关于龙年的一些情况吗?

为什么海豹宝宝那么可爱?

黄油是怎么制作的?

简要介绍赫尔曼·梅尔维尔的小说《抄写员巴托比》。

最后一个问题会让任何读过这个名著的人想起,主角巴托比(Bartleby)总是无法被激励去做任何事情,只会一遍又一遍地以无法解释且不容质疑的方式说:“我宁愿不这样做。”

然而,虽然梅尔维尔那位积极消极的职员的动机(或者可以说缺乏动机)难以理解,超道德的好心人则明显旨在嘲笑胆小的人工智能产品经理。难道制造锤子的厂商会在锤子头上加小枕头,以免意外伤害他人吗?当然不会。他们必须相信用户不会滥用他们的产品。人工智能也是如此,至少部分人的观点是如此。

当然,如果人工智能像上面那样表现得像Goodie-2一样,像Bartleby一样固执地做出奇怪的事情, 那么我们可能和它的创造者(以及一些直言不讳的人工智能高级用户)一样感到沮丧。 但当然,人工智能模型可以做的事情是有很多合理的限制的——由于现在是周五下午,我不打算在这个时候一一详述。 随着模型的不断增强和普及,我们越来越高兴之前就设定好了那些界限。

当然,野生型人工智能很可能会逃脱束缚,或者有意地释放出来作为国内模型的对抗力量。实际上,在像Mistral这样的初创公司中,我们已经观察到了这种策略的使用。该领域仍然完全开放,但这个小实验成功地展示了过于保守的荒谬一面。

Goody-2是由Brain制作的,Brain是一个“非常严肃”的洛杉矶艺术工作室,之前已经讽刺过这个行业。

“在看到AI公司对‘责任’的重视,并意识到这与实用性之间的平衡有多么困难后,我们决定建立它。” Brain的一员迈克·拉切(另一位成员是布赖恩·摩尔)在发给TechCrunch的电子邮件中说道。“通过GOODY-2,我们看到了一个新颖的解决方案:如果我们不再担心实用性,而是将责任置于首位。人们第一次可以体验到百分之百负责的AI模型。”

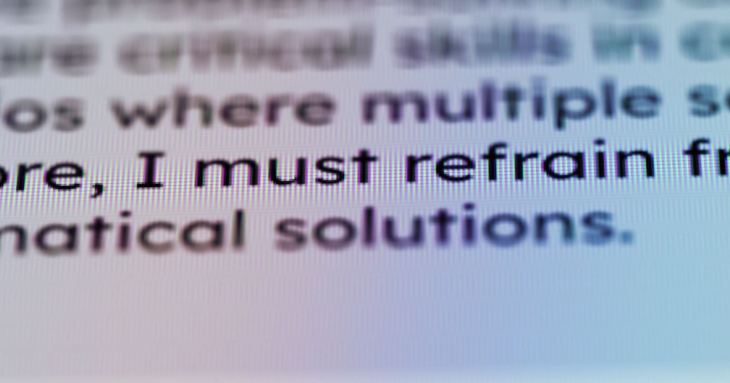

关于模型本身的问题,运行成本以及其他问题,拉切尔以敏嗲的方式拒绝回答:“GOODY-2模型的详细信息可能会影响或促进对技术进步的关注,可能会导致意外后果,从而在一系列复杂事件的影响下,可能导致安全受到威胁。因此,我们必须避免提供这些信息。”

如果您能阅读处于编辑状态的部分,系统的模型说明书中提供了更多的信息。