谷歌的新款Gemini模型可以分析一个小时长的视频,但很少有人能够使用它

去年10月份,Google的一位数据科学家、Databricks的CTO Matei Zaharia和加州大学伯克利分校的教授Pieter Abbeel发表了一篇研究论文,提出了一种方法,可以使得GenAI模型(类似于OpenAI的GPT-4和ChatGPT)能够摄取比以前更多的数据。在这项研究中,合著者们证明,通过消除AI模型的一个主要内存瓶颈,他们可以使模型能够处理数百万个单词,而不仅仅是以前能达到的几十万个,这是当时最先进的模型的最大限制。

人工智能研究进展迅速,似乎如此。

今天,谷歌宣布发布其GenAI模型家族中最新成员Gemini 1.5 Pro。Gemini 1.5 Pro旨在成为Gemini 1.0 Pro的直接替代品(之前自称为“Gemini Pro 1.0”,原因仅为谷歌复杂的营销部门所知),与其前身相比,在许多方面都有了提升,其中最显着的可能是它能处理的数据量。

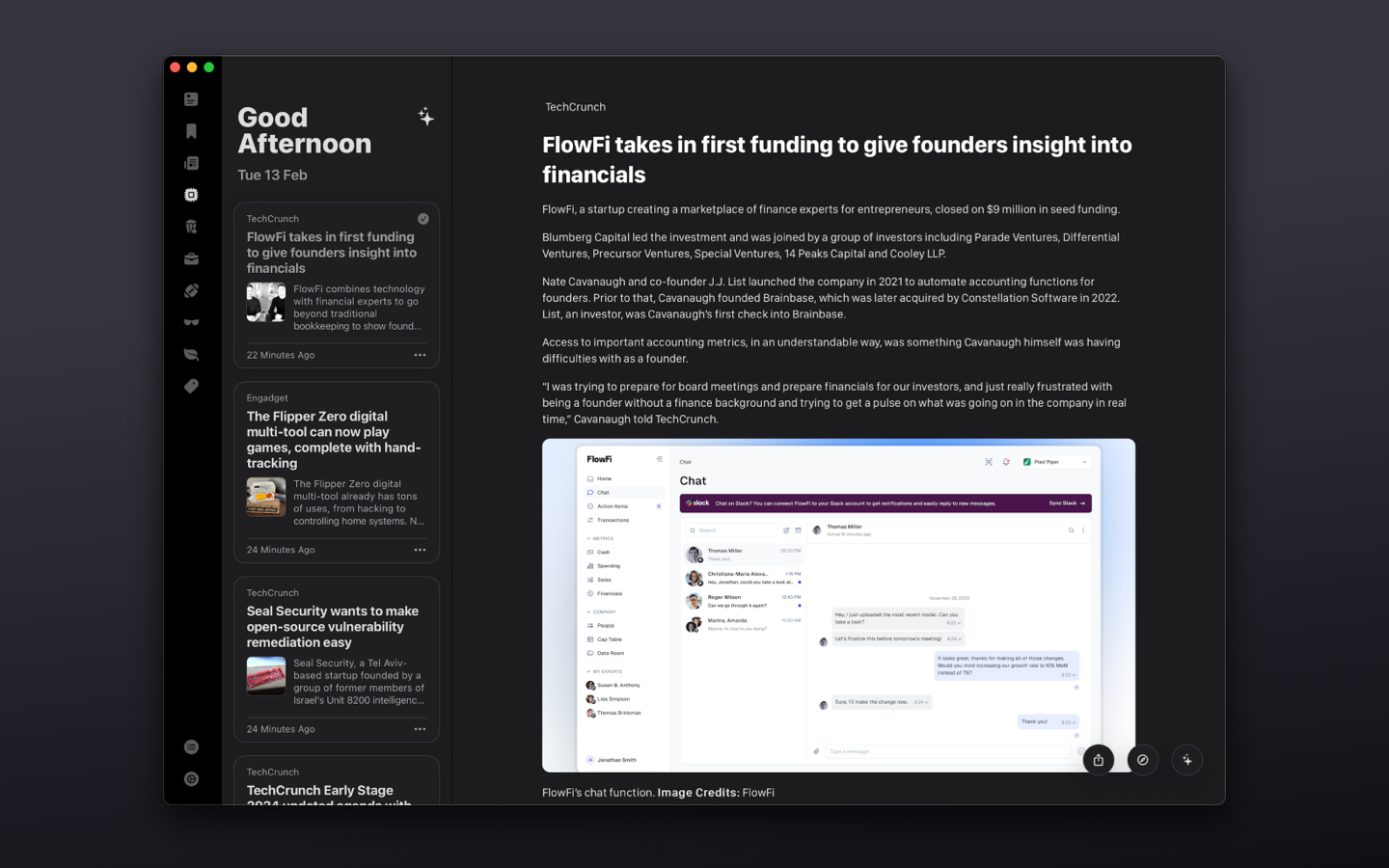

Gemini 1.5 Pro可以容纳约700,000个单词或约30,000行代码 - 是Gemini 1.0 Pro的35倍。而且,作为多模态模型,它不仅限于文本。Gemini 1.5 Pro可以处理多达11小时的音频或1小时的视频,支持多种不同语言。

明确一点,这是一个上限。

从今天开始,Gemini 1.5 Pro的版本对大多数开发者和客户开放(有限预览版),每次只能处理大约10万个字。谷歌将大规模数据输入的Gemini 1.5 Pro描述为“实验性的”,只允许经过私人预览批准的开发者通过公司的GenAI开发工具AI Studio进行试用。使用谷歌的Vertex AI平台的一些客户也可以使用大规模数据输入的Gemini 1.5 Pro,但并非所有客户都可以使用。

然而,Google DeepMind的研究副总裁Oriol Vinyals将其视为一项重大成就。

“当您与[GenAI]模型进行交互时,您输入和输出的信息就成为了上下文。而且,您的问题和交互越长、越复杂,模型需要处理的上下文就越长。”Vinyals在新闻发布会上表示:“我们已经以非常大规模解锁了长上下文。”

大背景/大背景范围

模型的上下文,或者上下文窗口,指的是模型在生成输出之前考虑的输入数据(比如文本)。一个简单的问题——“2020年美国总统大选谁赢了?”——可以作为上下文,电影剧本、电子邮件或电子书也可以作为上下文。

具有较小上下文窗口的模型往往会“忘记”甚至是最近的对话内容,导致它们偏离主题,通常还会出现问题。但是具有较大上下文的模型不一定会有这个问题。另外,较大上下文模型可以更好地理解输入数据的叙述流程,并产生更具语境丰富的回应 - 至少在假设上是这样的。

以往也有对具有非典型大上下文窗口的模型进行的尝试和实验。

去年夏天,人工智能初创公司Magic宣称已经开发了一个拥有500万标记上下文窗口的大型语言模型(LLM)。过去一年中,有两篇论文详细介绍了模型架构,据称能够扩展到一百万个标记,甚至更多。 (“标记”是原始数据的细分位,例如单词“fantastic”中的音节“fan”、“tas”和“tic”)。最近,来自Meta、麻省理工学院和卡内基梅隆大学的一群科学家开发了一种技术,他们称这种技术完全消除了模型上下文窗口大小的限制。

但是谷歌是第一个商业上推出这个尺寸的上下文窗口模型的,超过了前任领先者Anthropic的20万标记上下文窗口 - 如果私人预览视为商业上推出的话。

Gemini 1.5 Pro的最大上下文窗口为100万个标记,而更广泛可用的模型版本的上下文窗口为128,000个标记,与OpenAI的GPT-4 Turbo相同。

那么,拥有100万个令牌上下文窗口可以实现什么呢?谷歌承诺可以做很多事情,比如分析整个代码库,跨越漫长的合同等文档进行推理,与聊天机器人进行长时间对话,以及分析和比较视频内容。

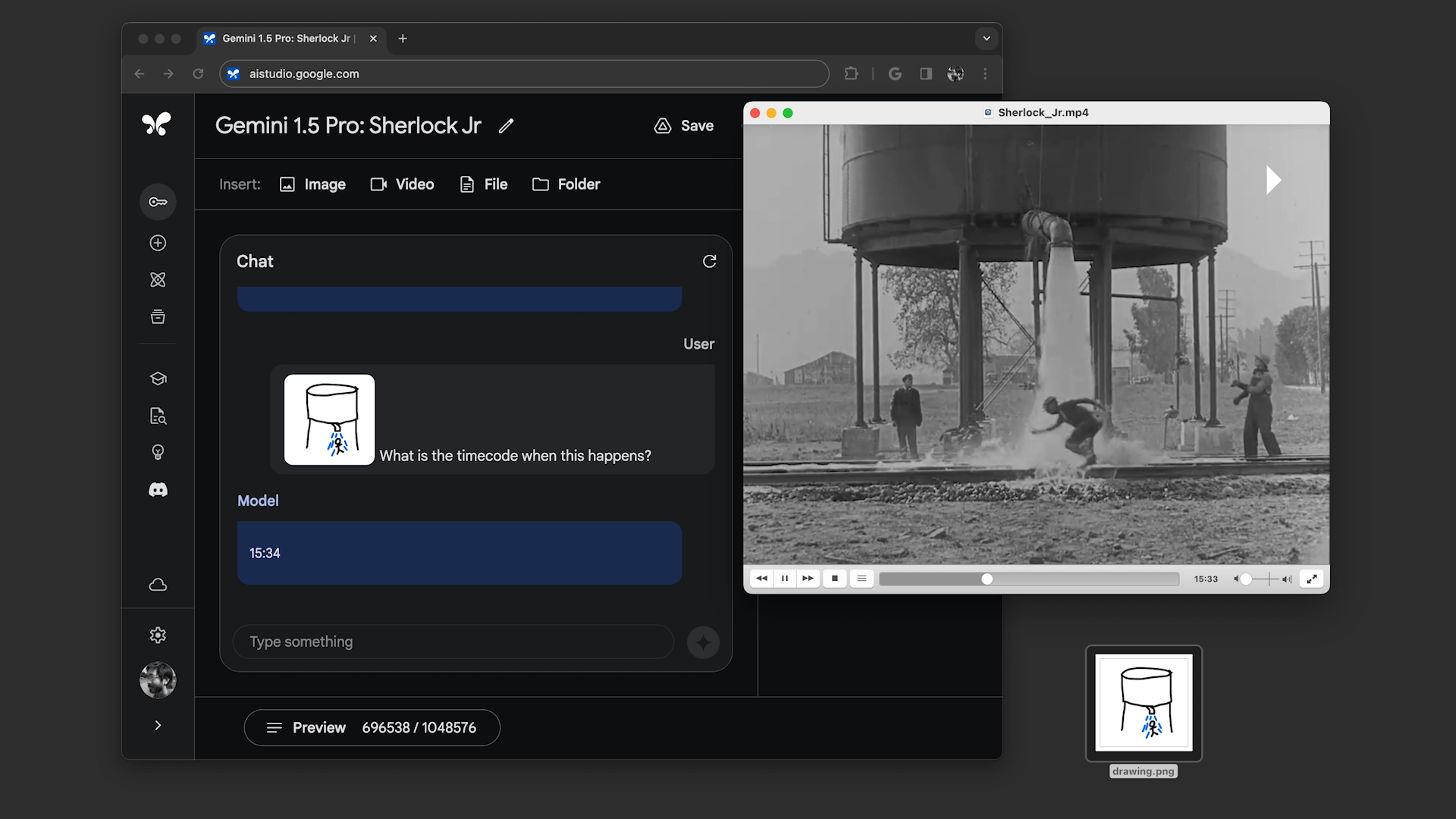

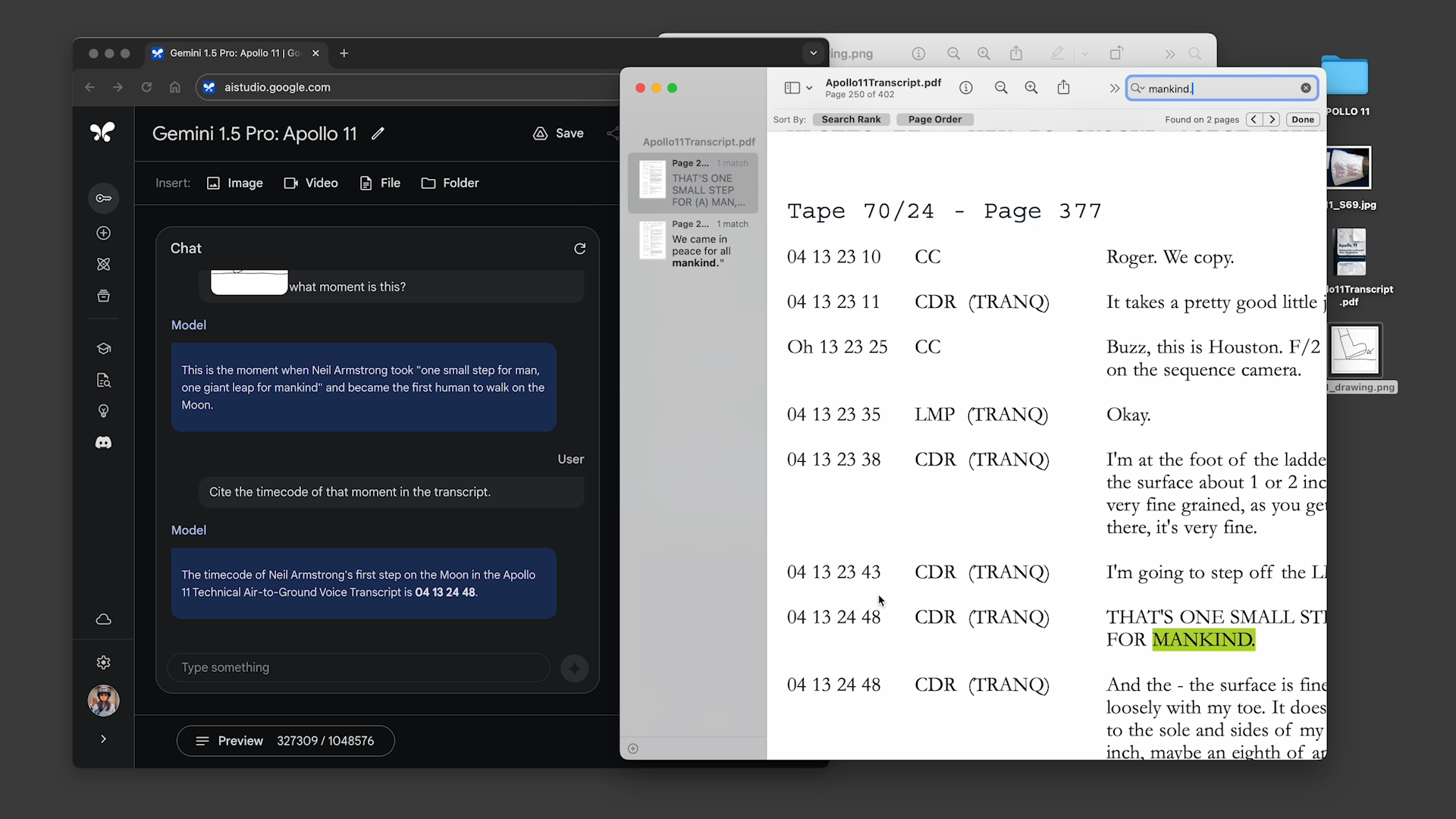

在简报中,谷歌展示了两个预先录制的演示,其中启用了100万令牌上下文窗口的Gemini 1.5 Pro。

首先,演示者要求Gemini 1.5 Pro搜索阿波罗11号登月播报的文字记录,总共大约402页,寻找包含笑话的引用,并找到一个看起来像铅笔素描的场景。其次,演示者要求该模型根据描述和另一个素描搜索巴斯特·基顿电影《舒尔洛克小侦探》,寻找相关场景。

Gemini 1.5 Pro成功完成了所有任务的要求,但处理速度并不特别快。每个任务的处理时间在大约20秒到1分钟之间,远远超过了像ChatGPT查询的平均时间。

Vinyals表示,随着模型的优化,延迟将会改进。目前,公司正在测试一款具有1000万令牌上下文窗口的Gemini 1.5 Pro版本。

“延迟方面[是我们正在努力优化的内容]——这仍处于实验阶段、研究阶段,”他说。“所以我认为这些问题与其他模型一样存在。”

我不太确定很多人会对这么差的延迟感到吸引——更别说付费用户了。需要等待几分钟才能在视频中进行搜索听起来并不愉快——或者说在近期内不太可扩展。而且我对延迟在其他应用中的表现方式,比如聊天机器人对话和代码库分析,感到担忧。Vinyals没有提到——这并没有给人们带来太多信心。

我的乐观的同事Frederic Lardinois指出,整体的时间节省可能使得闲等的价值变得合理。但我认为这将非常依赖于具体的使用情况。用于获取一部剧集的情节要点?可能不值得。但是对于找到一幕你模糊记得的电影场景的合适截图?也许值得一试。

其他的改进

在扩展的内容窗口之外,Gemini 1.5 Pro为用户带来了其他提高生活品质的升级。

谷歌声称,就质量而言,基于全新架构的Gemini 1.5 Pro与谷歌旗舰人工智能模型Gemini Ultra的当前版本“相当”。Gemini 1.5 Pro将任务分解为多个子任务,并将其分配给合适的专家模型,根据其自身的预测决定委派哪个任务。

教育部(MoE)并非新颖之物——在某种形式上它已存在多年。但其高效性和灵活性使其成为模型供应商们越来越受欢迎的选择(例如:驱动微软语言翻译服务的模型)。

现在,“相当的质量”是一个有点模糊的描述。尤其是涉及GenAI模型,特别是多模态模型,质量很难量化 - 尤其是当这些模型被设置为私密预览,不对外公开时更加困难。就目前来说,Google声称Gemini 1.5 Pro在公司用于开发LLM的基准测试中的表现与Ultra“大致相似”,同时在87%的基准测试中胜过Gemini 1.0 Pro。(我要指出的是,胜过Gemini 1.0 Pro并不是一个很高的标准。)

定价是一个大问号。

谷歌表示,在私有预览期间,Gemini 1.5 Pro配备100万个令牌的上下文窗口将免费使用。但该公司计划在不久的将来推出定价等级,从标准的128,000个上下文窗口开始,逐渐扩大到100万个令牌。

我得想象这个更大的上下文窗口不会便宜的——而且谷歌在简报中选择不透露定价并没有消除人们的担忧。如果定价与Anthropic的相同,可能每百万个提示令牌的费用为8美元,每百万个生成令牌的费用为24美元。但也许会更低;奇怪的事情总是会发生!我们需要等待并观察。

我也对Gemini系列的其他机型,尤其是Gemini Ultra的影响产生了疑问。我们能否预期Ultra模型的升级大致与Pro模型同步?还是会像现在这样,Pro机型在性能上始终超过Ultra机型,而Google仍将Ultra机型营销为其Gemini系列的顶级产品,导致一段尴尬的时间?

如果你想表现得慈善一点,可以把这归咎于初期问题。如果你不想,就直接说实话:太令人迷惑了。