扩散变压器是OpenAI的Sora的关键,它们将颠覆GenAI

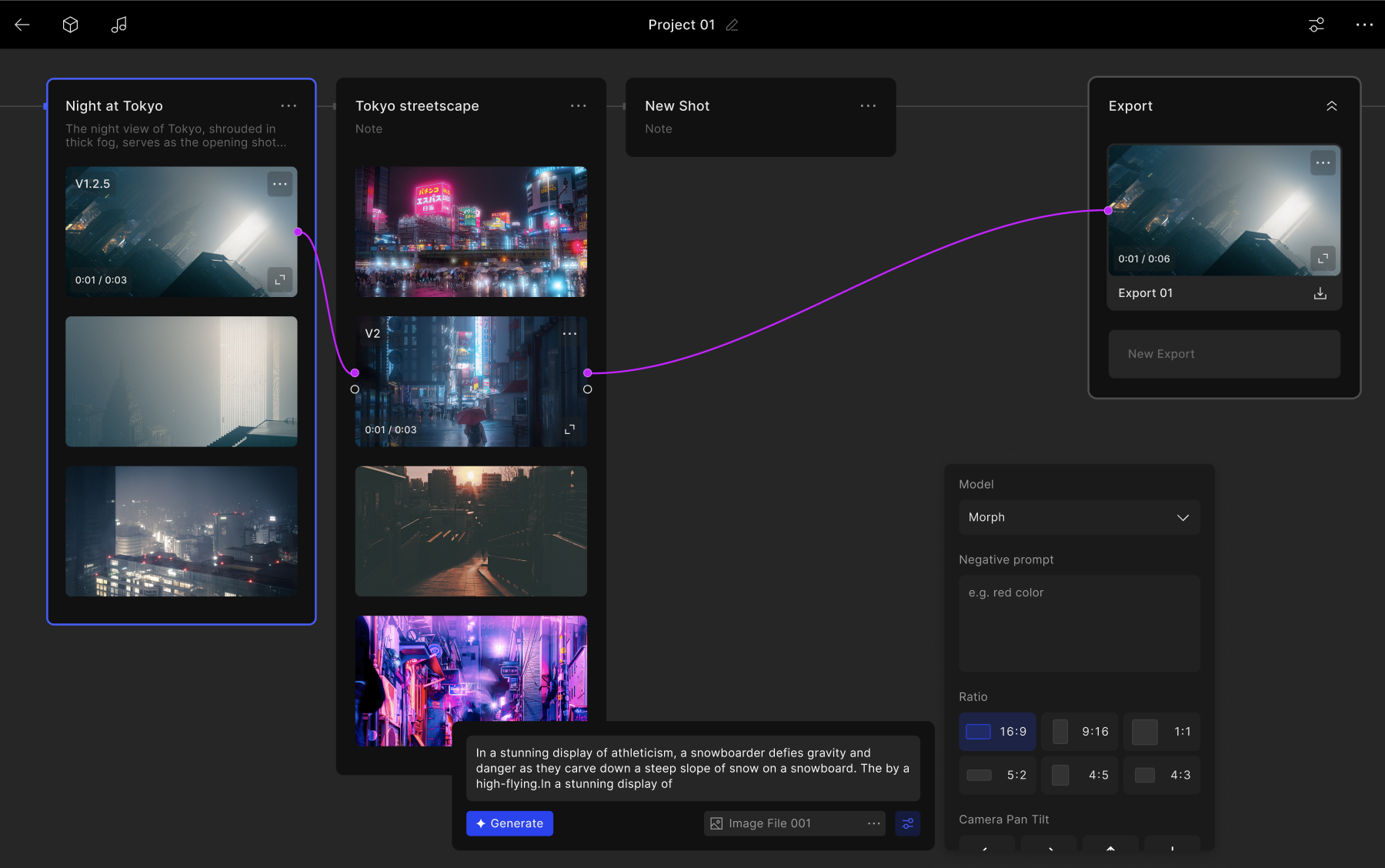

OpenAI的Sora,可以即时生成视频和交互式3D环境,展示了GenAI领域的尖端技术,是一项里程碑式的成就。

然而耐人寻味的是,其中导致这种现象的创新之一,被俗称为扩散变压器的人工智能模型架构,在 AI 研究领域已经出现数年。

据称,扩散变压器也为人工智能初创公司稳定AI的最新图像生成器Stable Diffusion 3.0提供了动力,预计将通过使GenAI模型能够扩大到以前无法实现的规模,来改变GenAI领域。

纽约大学计算机科学教授谢赛宁(Saining Xie)于2022年6月开始了这项研究项目,该项目孵化了扩散变压器。谢赛宁与威廉·皮布尔斯(William Peebles)合作,皮布尔斯在Meta的人工智能研究实验室实习时曾是他的学生,现在是OpenAI的Sora项目的共同负责人。谢赛宁将机器学习中的两个概念——扩散和变压器——结合起来,创造出了扩散变压器。

大多数现代AI动力媒体生成器,包括OpenAI的DALL-E 3,在输出图像、视频、语音、音乐、3D网格、艺术品等时依赖一种称为扩散的过程。

这可能不是最直观的想法,但基本上,就是将噪音逐渐添加到一个媒体片段,比如一张图片,直到它变得无法识别。这一过程重复进行,构建出一组有噪音的媒体数据集。当扩散模型在此数据集上训练时,它会学习如何逐渐减去噪音,逐步接近目标输出的媒体片段(比如一幅新图片)。

扩散模型通常会有一个称为U-Net的“骨架”或类似引擎。U-Net骨架学习估计要去除的噪音,而且做得很好。但是,U-Net复杂,具有特殊设计的模块,可能会显著减慢扩散流程。

幸运的是,变压器可以取代U型网络,并在此过程中提高效率和性能。

变形金刚是复杂推理任务的首选架构,驱动类似GPT-4、Gemini和ChatGPT这样的模型。它们有几个独特特征,但变形金刚最显著的特点是它们的“注意机制”。对于每个输入数据(在扩散的情况下,图像噪音),变形金刚权衡每个其他输入的相关性(图像中的其他噪音),并从中汲取以生成输出(估计图像噪音)。

注意机制不仅使变换器比其他模型架构更简单,而且使架构可并行化。换句话说,可以训练更大的变换器模型,并且计算量会显著增加,但并非难以达到。

谢在电子邮件采访中告诉TechCrunch:“变压器在扩散过程中所起的作用类似于引擎升级。引入变压器……标志着可伸缩性和效果方面的重大飞跃。这在像Sora这样的模型中尤为明显,它们通过训练大量视频数据和利用大量模型参数展示了在大规模应用时变压器的转化潜力。”

所以,鉴于扩散变压器的构想已经存在一段时间,为什么要等很多年才有像Sora和Stable Diffusion这样的项目开始利用它们呢?谢认为,拥有可扩展的骨干模型的重要性直到相对最近才被认识到。

他说:“Sora团队真的超出了预期,展示了这种方法在大规模上可以做到更多的事情。他们基本上明确表示,现在扩散模型中不再使用U-Nets,而是转向transformers。”

谢说,扩散转换器应该是现有扩散模型的简单替代品,无论这些模型生成图像、视频、音频还是其他形式的媒体。当前训练扩散转换器的过程可能会引入一些低效和性能损失,但谢相信这在长期内可以解决。

“主要观点非常简单明了:忘掉U-Net,转向transformers,因为它们更快、效果更好、可扩展性更强”,他说道。“我对将内容理解和创造领域整合到扩散transformers框架中很感兴趣。目前,这两个领域就像是两个不同的世界 —— 一个是为了理解,另一个是为了创造。我设想未来这两个方面会整合在一起,我相信实现这种整合需要对底层架构进行标准化,而transformers是实现这一目标的理想选择。”

如果Sora和稳定扩散3.0是扩散变压器的未来预期,我想我们要经历一场惊险刺激的旅程。