本周人工智能新闻:苹果不会透露产品制作过程

大家好,欢迎阅读科技博客的人工智能专栏。

本周,人工智能领域,苹果成为焦点。

在苹果公司的全球开发者大会(WWDC)上,苹果发布了苹果智能,这是其期待已久的生态系统范围内的生成式人工智能推动。苹果智能驱动了一系列功能,从升级版Siri到AI生成的表情符号,再到可以从照片中移除不需要的人和物体的照片编辑工具。

公司承诺,苹果智能是建立在安全核心之上的,还提供高度个性化的体验。

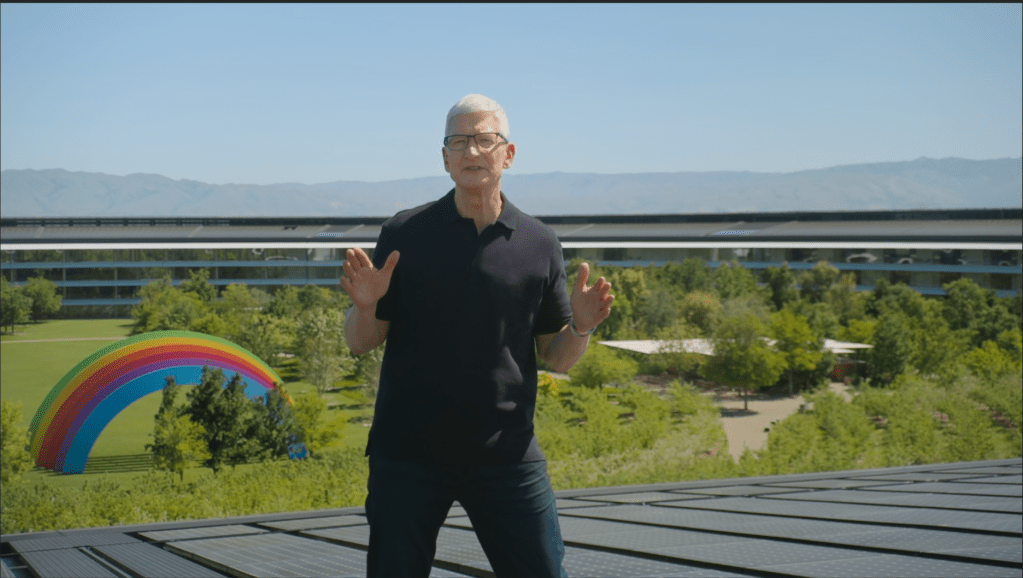

周一的主题演讲中,首席执行官蒂姆·库克指出:“它必须了解你并基于你的个人背景,比如你的日常生活,你的人际关系,你的交流等等。” “所有这些都超越了人工智能。这是个人智能,也是苹果的下一个重要步骤。”

苹果的智能技术一如既往地“苹果”:它隐藏了繁琐的技术,却展现了明显直观的有用功能。(库克从来没有提及过“大语言模型”这个短语。)但作为一个以写作人工智能技术为生的人,我希望苹果能更加透明一点,至少在这一次,告诉我们这个“香肠”是如何制作的。

以苹果的模型训练实践为例。苹果在一篇博客文章中透露,它训练驱动苹果智能的人工智能模型时会使用准许许可的数据集和公开网络的信息。发布商可以选择不参与未来的训练。但如果你是一位艺术家,好奇自己的作品是否被纳入苹果的初始训练?咱们无从得知,真是没办法。

这种保密可能是出于竞争原因。但我怀疑也是为了保护苹果免受法律挑战,特别是与版权相关的挑战。法院尚未决定像苹果这样的供应商是否有权在不赔偿或给予数据创作者荣誉的情况下使用公共数据,换句话说,是否公平使用原则适用于生成式人工智能。

看到苹果公司,经常标榜自己是技术政策的理性倡导者,却暗中支持合理使用的论点,有点令人失望。在营销的幌子下,苹果可以声称对人工智能采取负责任和审慎的态度,而实际上可能已经未经许可地使用了创作者的作品。

一点解释就可以解决许多问题。很遗憾我们还没有得到解释,我不抱太大希望很快会得到解释,除非通过诉讼。

新闻

苹果的顶尖人工智能功能:本人总结了本周苹果在WWDC主题演讲中宣布的顶尖人工智能功能,包括升级版的Siri和与OpenAI的ChatGPT的深度集成。

OpenAI聘用高管:本周OpenAI聘请了超本地社交网络Nextdoor的前首席执行官Sarah Friar担任首席财务官,以及曾在Instagram和Twitter领导产品开发的Kevin Weil担任首席产品官。

雅虎邮箱现在加入了更多人工智能功能:本周,雅虎(科技媒体科技博客的母公司)更新了雅虎邮箱,加入了新的人工智能功能,包括人工智能生成的邮件摘要。谷歌最近也推出了类似的生成式摘要功能,但需要付费才能使用。

有争议的观点:卡内基梅隆大学最近的一项研究发现,并非所有生成式人工智能模型都是一视同仁的,特别是在处理极具争议的主题时。

声音生成器:Stability AI是AI艺术生成器Stable Diffusion的创业公司,他们发布了一个开放的AI模型,用于生成声音和歌曲,据称该模型是 exclusively 在免版税录音的基础上训练的。

本周研究论文

谷歌认为它可以为个人健康建立生成式人工智能模型,或者至少朝着这个方向迈出初步的步伐。

谷歌研究人员在官方AI博客上发表了一篇新论文,揭开了个人健康大语言模型(PH-LLM)的面纱,这是谷歌Gemini模型的一个经过精心调整的版本。PH-LLM旨在通过读取智能手表等可穿戴设备的心率和呼吸率数据,为改善睡眠和健身提供建议。

为了测试PH-LLM提供有用的健康建议的能力,研究人员创建了近900例涉及美国受试者的睡眠和健身案例研究。他们发现,PH-LLM提出的睡眠建议接近于但不如人类睡眠专家提出的建议好。

研究人员表示,PH-LLM可帮助对“个人健康应用”的生理数据进行情境化处理。谷歌健身跟踪应用也许是一个例子;我不会感到意外如果最终看到PH-LLM为谷歌健身应用或其他健身应用提供动力支持新功能。

本周模特

苹果公司在其博客中详细介绍了其新的设备内和基于云的生成式人工智能模型,这些模型组成了苹果智能套件。然而,尽管这篇文章写得很长,但它对模型的能力揭示的并不多。以下是我们对其最佳解释的尝试:

苹果推出的无名设备模型体积小巧,无疑是为了能够在iPhone 15 Pro和Pro Max等苹果设备上离线运行。该模型包含30亿个参数,“参数”是模型的基本定义部分,决定了它在处理问题时的能力,比如生成文本。这使得它与谷歌的本地Gemini模型Gemini Nano相当,后者拥有18亿个参数和32.5亿个参数两种大小可选。

与此同时,服务器模型要大得多(具体大多少,苹果没有透露)。我们所知道的是,它比设备上的模型更有能力。虽然设备上的模型在苹果列出的基准测试中的表现与微软的Phi-3-mini、Mistral的Mistral 7B和谷歌的Gemma 7B等模型持平,但苹果声称服务器模型与OpenAI较老的旗舰模型GPT-3.5 Turbo相比“表现上佳”。

苹果也表示,在设备模型和服务器模型上,都比类似规模的模型更不太可能出错(即,产生有害内容)。这也许是真的,但笔者会在有机会测试苹果智能之前保留评判。

混合袋

本周标志着GPT-1发布6周年,它是GPT-4o的前身,是OpenAI最新的旗舰生成式人工智能模型。虽然深度学习可能会遇到瓶颈,但这个领域已经取得了难以置信的进展。

考虑到GPT-1在一个包含4.5GB文本数据集的训练上花了一个月的时间(BookCorpus,包含约7000本未发表的小说)。而GPT-3,参数数量几乎是GPT-1的1500倍,并且在生成和分析散文方面显著更加复杂,花了34天来训练。对于规模化来说,这是怎么样的呢?

GPT-1之所以开创性在于其训练方式。先前的技术依赖于大量手动标记的数据,限制了它们的实用性(手动标记数据耗时且费力)。但GPT-1不同,它主要依靠未标记的数据进行训练,从中“学会”执行各种任务(比如写作文章)。

许多专家认为,短时间内我们不会看到像GPT-1那样有意义的范式转变。但另一方面,世界也没有预料到GPT-1的出现。