新闻媒体指责Perplexity存在剽窃和不道德的网络抓取行为

在生成AI时代,聊天机器人可以根据从互联网上获取的内容提供详细答案时,公平使用与剽窃之间、常规网络抓取与不道德的摘要之间的界限变得非常模糊。

Perplexity AI是一家初创公司,它将搜索引擎与大型语言模型相结合,生成详细的答复,而不仅仅是链接。与OpenAI的ChatGPT和Anthropic的Claude不同,Perplexity不自己训练基础的AI模型,而是使用开放或商业可得的模型来获取互联网上的信息并将其翻译成答案。

以下是翻译好的简体中文版本: 然而,六月份的一系列指控表明,这家初创公司的做法涉嫌不道德。《福布斯》指责Perplexity在其测试版Perplexity Pages功能中涉嫌抄袭其一篇新闻文章。《连线》也指控Perplexity非法抓取其网站以及其他网站的内容。

截至4月份,Perplexity正在筹集2.5亿美元,估值接近30亿美元,该公司坚称自己没有做错任何事情。这家得到Nvidia和Jeff Bezos支持的公司表示,他们已经尊重了出版商的要求,不会擦取内容,并且他们是在公平使用版权法的范围内运作的。

情况很复杂。其中涉及到两个概念的细微差别。第一个是“机器人排除协议”,这是网站用来表明不希望其内容被网络爬虫访问或使用的标准。第二个是版权法中的合理使用,它为在特定情况下允许未经许可或付费使用受版权保护的材料建立了法律框架。

暗中抓取网页内容

《连线》6月19日的报道称,Perplexity公司无视了机器人排除协议,秘密地抓取了网站的部分内容,而这些内容网站的发布者并不希望被机器人访问。《连线》报道称,他们观察到Perplexity公司的一台机器在其自家新闻网站以及康泰纳仕旗下的其他出版物上执行了这一行为。

报告指出,开发者Robb Knight进行了类似的实验,并得出了相同的结论。

以下是翻译好的简体中文文本: "Wired 的记者和 Knight 都测试了他们的怀疑,通过让 Perplexity 总结一系列的网址,并在服务器端观察与 Perplexity 关联的 IP 地址访问这些网站。Perplexity 然后从这些网址中“总结”文本 — 虽然在 Wired 为此目的创建的一个虚拟网站的情况下,它直接返回了页面上的文本。"

这就是 Robots Exclusion Protocol 的细微之处发挥作用的地方。

网页抓取技术上是指自动化软件,也称为网络爬虫,通过搜索网络来索引和收集网站上的信息。像谷歌这样的搜索引擎会这样做,以便将网页包含在搜索结果中。其他公司和研究人员使用爬虫从互联网上收集数据,用于市场分析、学术研究,以及我们现在了解到的训练机器学习模型。

符合此协议的网络爬虫将首先查找网站源代码中的“robots.txt”文件,以了解什么是允许的,什么是不允许的-今天,通常不允许的是对出版商网站进行大规模的网络数据抓取以建立大型训练数据集用于人工智能。搜索引擎和人工智能公司,包括Perplexity,已经声明他们遵守该协议,但并没有法律义务这样做。

Perplexity的业务负责人Dmitry Shevelenko告诉TechCrunch,总结URL并不等同于爬取。Shevelenko表示:“爬取是指你只是四处搜集信息并将其添加到索引中。”他指出,只有当用户将URL放入查询时,Perplexity的IP才可能出现为“受robots.txt禁止访问的网站”的访问者,这“并不符合爬取的定义”。

"谢夫连科说,我们只是响应一个直接而具体的用户请求,前往那个网址。"

换句话说,如果用户手动提供一个URL给人工智能,迷惑度表示其人工智能并不是作为网络爬虫,而是作为一个辅助用户检索和处理他们请求的信息的工具。

但对《连线》和许多其他出版商来说,这没有区别,因为如果每天都要访问一个URL并从中提取信息来总结文本,那看起来就非常像是抓取网页数据。

《连线》杂志还报道称,亚马逊网络服务(AWS),Perplexity的云服务提供商之一,正在调查该初创公司是否无视robots.txt协议,从用户在提示中引用的网页上抓取数据。AWS告诉TechCrunch,称《连线》的报道不准确,并告诉该媒体,他们正在处理类似于其他任何报告滥用服务的媒体查询。

剽窃还是合理使用?

《连线》和《福布斯》杂志也指控Perplexity有抄袭行为。讽刺的是,《连线》称Perplexity抄袭了一篇文章,而这篇文章正是揭露这家初创公司偷偷获取其网络内容的文章。

《连线》记者表示,Perplexity聊天机器人“生成了一个六段、287字的文本,紧密总结了故事的结论和用于得出结论的证据。”一句话恰好复制了原故事中的一句话;《连线》称这构成了抄袭行为。彭特尔研究所的指导方针表示,如果作者(或人工智能)从原始来源作品中连续使用了七个字,那么这就可能构成了抄袭。

福布斯也指控Perplexity涉嫌剽窃。这家新闻网站在6月初发布了一份调查报告,内容是谷歌CEO埃里克·施密特的新创业公司正在大力招募人才,并正在测试具有军事应用的人工智能无人机。次日,福布斯编辑约翰·帕茨科斯基在X上发帖称,Perplexity将这一独家新闻作为其测试版功能之一,即Perplexity Pages,重新发布了。

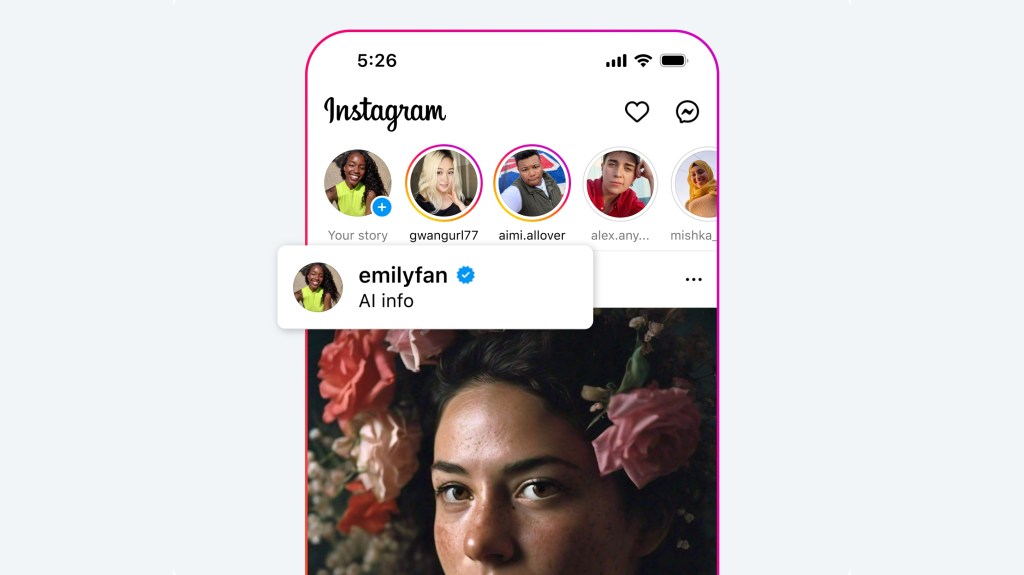

Perplexity页面是一项新工具,目前仅限于特定的Perplexity订阅者使用,该工具承诺帮助用户将研究转化为“视觉惊人、内容全面”的内容,据Perplexity称。该网站上的这类内容的例子来自这家初创公司的员工,包括“初学者打击乐指南”或“史蒂夫·乔布斯:有远见的CEO”等文章。

Paczkowski写道:“它剽窃了我们大部分的报道。它引用了我们和一些转发我们的人,但以最容易被忽视的方式。”

福布斯报道说,Perplexity团队筛选的许多帖子“与包括福布斯、CNBC和彭博社在内的多家媒体的原创报道非常相似。”福布斯称这些帖子获得了数万次的浏览量,并且在文章中并没有明确提及任何媒体。相反,Perplexity的文章中包含了“小巧易错过的标志,链接到这些媒体的网站。”

此外,福布斯表示,关于施密特的帖子“几乎使用了相同的措辞”与福布斯的独家报道一致。聚合内容还包括一张由福布斯设计团队创建的图片,看起来被Perplexity稍作修改。

Perplexity的首席执行官Aravind Srinivas当时对《福布斯》的回应是,未来公司会更突出地引用来源——这并非万无一失的解决方案,因为引用本身也面临技术困难。ChatGPT和其他模型出现了虚构的链接,而由于Perplexity使用OpenAI模型,很可能也会受到这种幻觉的影响。事实上,《连线》报道称,Perplexity出现了整个故事的幻觉现象。

除了注意到Perplexity的“粗糙之处”外,Srinivas和公司大部分都坚定支持Perplexity使用此类内容进行摘要的权利。

这就是公平使用的微妙之处。抄袭虽然不被认可,但在技术上并不违法。

根据美国版权局,合法使用作品的有限部分,包括引用,用于评论、批评、新闻报道和学术报告等目的。Perplexity等人工智能公司提出,提供文章摘要属于合理使用范围内。

谢维连科说:“没有人拥有事实的垄断。一旦事实曝光,就应该让每个人都能使用。”

谢维连科把普洛珀克西的摘要比作记者通常如何利用其他新闻来源的信息来支持自己的报道。

加州大学洛杉矶分校科技、法律与政策研究所的法学教授马克·麦肯纳告诉TechCrunch,这种情况并不容易澄清。在公平使用的案例中,法院会权衡摘要是否使用了原始文章的大量表达,而不仅仅是想法。他们还可能会审查阅读摘要是否可能成为阅读文章的替代。

以下是翻译的简体中文版本: 麦肯纳说:“这里并没有明确的界限。因此,如果《迷茫》仅仅陈述一篇文章的事实或报道内容,那么它使用的是不受版权保护的作品部分。那就是事实和观念。但是,如果摘要包含实际的表达和文字,那么它看起来越像是复制,而不仅仅是一份摘要。”

不幸的是,对于出版商来说,除非Perplexity使用完整表达(显然,在某些情况下是),否则其摘要可能不被视为侵犯合理使用权。

Perplexity如何保护自己

像OpenAI这样的人工智能公司已经与多家新闻出版商签订了媒体协议,以获取它们的现有和存档内容,用来训练他们的算法。作为回报,OpenAI承诺会在ChatGPT中回应用户的查询时展示这些出版商的新闻文章。(不过,正如Nieman Lab上周报道的,这方面还有一些需要解决的问题。)

Perplexity暂时没有宣布自己的一系列媒体交易,或许是在等待针对它的指控消散。但是该公司正全速推进与出版商的一系列广告收入分成交易。

这个想法是,Perplexity将开始在查询响应旁边展示广告,并且被引用在任何答案中内容的发布者将分享相应广告收入的一部分。Shevelenko表示,Perplexity还在努力让发布者可以使用其技术,这样他们可以构建问答体验,并在其网站和产品内部实现类似相关问题的功能。

但这只是制度性知识产权盗窃的挡箭牌吗?Perplexity并不是唯一一款会让人们完全看懂内容而不需要点击原始来源的聊天机器人。

如果像这样的人工智能爬虫继续获取出版商的作品并重新用于他们自己的业务,出版商将更难赚取广告收入。这意味着最终会有更少的内容可供爬取。当没有更多内容可供爬取时,生成式人工智能系统将转而在合成数据上进行训练,这可能导致一个地狱般的反馈循环,产生潜在偏见和不准确的内容。