“视觉”人工智能模型实际上是“盲”的吗?

最新一轮的语言模型,如 GPT-4o 和 Gemini 1.5 Pro,被吹捧为“多模态”,能够理解图像、音频以及文本——但一项新的研究表明,它们的理解方式可能并非如你所预期。事实上,它们可能根本就无法理解。

首先要说清楚,没有人宣称“这个人工智能能像人类一样看东西!”(好吧……也许有些人这么说过。)但用于推广这些模型的营销手段和基准测试会使用“视觉能力”、“视觉理解”之类的表述。他们谈论该模型如何看和分析图像及视频,说它能为你做从家庭作业到看比赛之类的任何事情。

因此,尽管这些公司的说法措辞巧妙,但很明显,他们想要表达的是该模型在某种意义上能够“看”。它确实能——但在某种程度上,就像它做数学或写故事一样:将输入数据中的模式与训练数据中的模式相匹配。这导致模型在某些看似微不足道的其他任务上以同样的方式失败,比如随机选一个数字。

奥本大学和阿尔伯塔大学的研究人员对当前人工智能模型的视觉理解进行了一项研究——在某些方面是非正式的,但却是系统的。他们给最大的多模态模型布置了一系列非常简单的视觉任务,比如询问两个形状是否重叠,图片中有多少个五边形,或者一个单词中哪个字母被圈了起来。(这里可以查看一个摘要微页面。)

它们是那种连一年级学生都能答对,但却给人工智能模型带来极大困难的东西。

该研究的合著者安·阮(Anh Nguyen)在给 TechCrunch 的一封电子邮件中写道:“我们的 7 项任务极其简单,人类能达到 100%的准确率。我们期望人工智能也能做到,但它们目前还做不到。我们要传达的信息是‘看,这些最优秀的模型仍然在失败。’”

进行重叠形状测试:这是能想到的最简单的视觉推理任务之一。面对两个要么稍微重叠、刚好接触,要么有一定距离的圆,这些模型不能始终得出正确答案。诚然,当两个圆相距较远时,GPT-4o 有超过 95%的正确率,但在距离为零或较小时,它的正确率仅为 18%!Gemini Pro 1.5 表现最佳,但在距离较近时仍然只有 70%的正确率。

(这些插图并未展示模型的确切性能,而是旨在表明模型在不同条件下的不一致性。每个模型的统计数据在论文中。)

或者,数数图像中相互嵌套的圆圈数量怎么样?我敢打赌,一匹高于平均水平的马都能做到。

当有 5 个环时,它们每次都能 100%答对——视觉人工智能干得漂亮!但再增加一个环就完全搞砸了结果。Gemini 就迷失了,一次都没答对。Sonnet-3.5 有三分之一的概率答对 6 次,GPT-4o 答对的概率略低于一半。再增加一个环会更难,但再增加一个对某些模型来说反而更容易了。

这个实验的重点仅仅是要表明,不管这些模型在做什么,它与我们所认为的“看”并不真正相符。毕竟,即使它们看得不好,我们也不会预料到 6 环、7 环、8 环和 9 环的图像在成功率上会有如此大的差异。

其他测试任务呈现出类似的模式:这并不是他们看得好或不好、推理得好或不好的问题,而是似乎存在某种其他原因,致使他们在一种情况下能够计数,而在另一种情况下却不能。

当然,一个潜在的答案就明摆在我们面前:为什么它们能如此准确地识别出五环图像,而在其他图像或五边形的识别上却表现得如此糟糕?(公平地说,Sonnet-3.5 在这方面做得相当不错。)因为在它们的训练数据中,五环图像显著存在:比如奥林匹克五环。

这个标志在训练数据中并非只是一遍又一遍地重复,而是很可能在替代文本、使用指南以及相关文章中有详细描述。但在他们的训练数据中,哪里能找到 6 个相互连接的环,或者 7 个呢?如果他们的回应能说明什么的话……哪里都找不到!他们根本不知道自己“看到”的是什么,对环、重叠或者任何此类概念都没有实际的视觉理解。

我询问了研究人员对他们所指责的模型的这种“盲目性”的看法。和我们使用的其他术语一样,它具有一种拟人化的特质,这种特质并不十分准确,但又难以避免。

阮写道:“我同意,‘失明’对于人类都有很多定义,对于人工智能对我们展示的图像的这种失明/不敏感类型,目前还没有一个词来描述。” “目前,还没有技术能够确切地可视化一个模型所看到的东西。而且它们的行为是输入文本提示、输入图像和数十亿个权重的复杂函数。”

他推测这些模型并非完全失明,而是它们从图像中提取的视觉信息是近似和抽象的,类似于“左边有个圆圈”。但这些模型没有进行视觉判断的手段,这使得它们的反应就像那些了解图像但实际上看不到图像的人的反应一样。

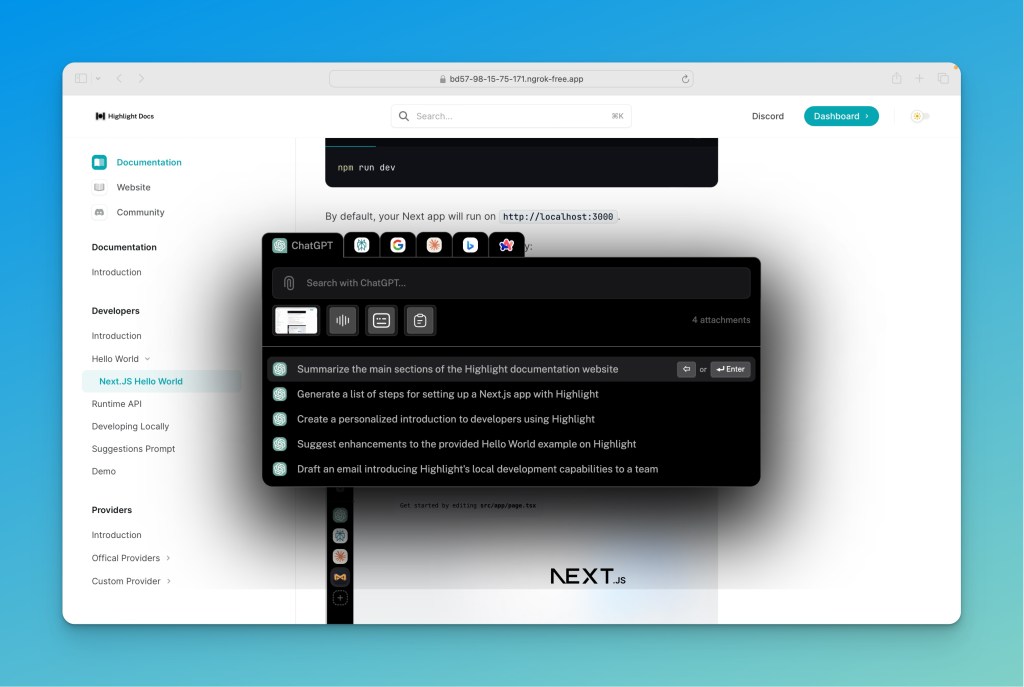

作为最后一个例子,阮氏(Nguyen)发了这个,这支持了上述假设:

当一个蓝色圆圈和一个绿色圆圈重叠(正如问题提示模型将其视为事实)时,通常会产生一个青色阴影区域,就像在维恩图中一样。如果有人问您这个问题,您或任何聪明人可能都会给出相同的答案,因为这完全合理……如果您闭上眼睛!但任何睁着眼睛的人都不会那样回答。

这一切是否意味着这些“视觉”人工智能模型毫无用处?绝非如此。无法对某些图像进行基本推理反映的是它们的基础能力,而非特定能力。这些模型中的每一个在诸如人类动作和表情、日常物品和场景的照片等方面可能都非常准确。而这也确实是它们旨在解读的内容。

如果我们依赖人工智能公司的营销来了解这些模型能做的一切,我们会认为它们具有完美的洞察力。像这样的研究是必要的,它表明,无论模型在判断一个人是坐着、走着还是跑着时可能有多准确,它们都不是以我们通常所认为的那种“看”的方式做到的(如果你愿意这么理解的话)。