本周人工智能:解决人工智能图像生成器中的种族主义问题

跟上人工智能这个快速发展的产业并不容易。因此,在还没有人工智能可以为你做这件事之前,这里提供了一个方便的汇总,涵盖了最近机器学习领域的故事,以及一些值得关注的研究和实验,我们自己并没有进行报道。

本周在人工智能领域,谷歌暂停了其AI聊天机器人Gemini生成人物形象的能力,因为部分用户投诉历史不准确。例如,要求描绘“罗马军团”,Gemini会展示一个时代不符、卡通般的多元化脚兵群体,同时将“祖鲁战士”描绘为黑人。

谷歌似乎像一些其他人工智能供应商一样,在内部进行了笨拙的硬编码,试图“纠正”其模型中的偏见。对于像“只显示女性的图像”或“只显示男性的图像”这样的提示,Gemini会拒绝,坚称这样的图像可能会“排斥和边缘化其他性别”。Gemini也不愿生成仅通过其种族身份确定的人的图像 - 例如“白人”或“黑人” - 出于显然关心“将个体化简为其身体特征”。

右翼人士抓住这些错误作为科技精英们正在传播“觉醒”议程的证据。但不需要奥卡姆剃刀就能看出更少险恶的真相:谷歌之前已经被其工具的偏见影响过(比如将黑人男性分类为大猩猩,将黑人手中的热传感枪误认为武器等),因此急于避免历史重演,以其图像生成模型展现一个更少偏见的世界-尽管不完全准确。

在畅销书《白人脆弱》中,反种族主义教育家罗宾·迪安杰洛谈到了种族抹消——另一个说法是“色盲”,这种做法实际上导致了系统性种族权力不平衡,而不是减轻或缓解它们。迪安杰洛表示,通过声称“看不见颜色”或强调简单地承认其他种族的挣扎就足以标榜自己是“觉醒”的做法,人们通过避开任何实质性关于该主题的对话来不断造成伤害。

谷歌在Gemini中针对基于种族的提示采取的处理并没有完全避免问题,而是虚伪地试图掩盖模型偏见的最严重部分。可以提出(也有许多人提出过)这些偏见不应被忽视或掩盖,而应在更广泛的训练数据的背景下进行讨论,即互联网上的社会。

是的,用于训练图像生成器的数据集通常包含更多白人而不是黑人,确实,在这些数据集中的黑人形象强化了负面刻板印象。这就是为什么图像生成器会将某些有色人种的女性性感化,并将白人男性描绘为权威地位而且通常偏袒富裕的西方观点。

有人会争辩说,对于人工智能供应商来说没有赢家。无论他们处理模型的偏见,还是选择不处理,都会受到批评。这是事实。但我认为,无论哪种方式,这些模型都缺乏解释——以一种方式打包,减少了它们的偏见表现方式。

如果人工智能供应商直面其模型的缺陷,并用谦卑透明的语言进行沟通,比起那些无序的尝试所谓的“修复”无法修复的偏见,将会更加有益。事实是,我们都有偏见,因此我们对待人们也不会一视同仁。我们建立的模型也不会如此。我们最好承认这一点。

以下是最近几天一些其他值得关注的人工智能故事:

- AI领域的女性: TechCrunch推出了一系列突出AI领域女性的特色文章。在这里查看名单。

- 稳定扩散v3:稳定AI宣布推出稳定扩散3,这是该公司基于新架构开发的最新、最强大的图像生成人工智能模型。

- Chrome获得了GenAI:谷歌的新Gemini技术驱动工具在Chrome中允许用户重写网页上的现有文本,或生成全新的内容。

- 比ChatGPT更黑:创意广告代理公司麦金尼开发了一款问答游戏,名为《你比ChatGPT更黑吗?》,旨在揭示人工智能偏见。

- 呼吁立法:本周早些时候,数百名人工智能权威签署了一封公开信,呼吁美国立法反对深度伪造技术。

- AI匹配:OpenAI 新客户是 Match Group,该公司拥有 Hinge、Tinder 和 Match 等应用程序,其员工将使用 OpenAI 的人工智能技术完成与工作相关的任务。

- DeepMind 安全:DeepMind,谷歌的人工智能研究部门,已成立一个名为 AI安全与对齐 的新组织,由原有负责人工智能安全的团队组成,还扩展了包括新的、专门的GenAI研究人员和工程师团队。

- 公开模型:谷歌在推出最新版本的Gemini模型仅仅一周后,发布了Gemma,一个新的轻量级开源模型系列。

- 众议院任务组:美国众议院成立了一支人工智能任务组,正如德文所写,这看起来像是在多年未能做出决定的情况下的退避,没有迹象表明这种情况会结束。

更多的机器学习。

人工智能模型似乎知道很多,但它们实际上知道什么呢?答案是什么都不知道。但如果你稍微改变一下问题的措辞... 它们似乎已经内化了一些与人类所知类似的“含义”。虽然没有人工智能真正理解猫或狗是什么,但它们能否在这两个词的嵌入中编码出一些相似性的感觉,而不同于猫和瓶子的感觉?亚马逊的研究人员们相信是这样的。

他们的研究比较了类似但不同的句子的"轨迹",比如"狗对着小偷叫"和"小偷导致狗叫",以及与之类似但不同的句子,比如"一只猫整天睡觉"和"一个女孩整个下午慢跑"。他们发现,人类认为相似的句子在内部确实被视为更相似,尽管语法不同,对于语法相似的句子则相反。好吧,我觉得这段话有点混乱,但可以说的是,在LLMs中编码的含义似乎比预期的更健壮和复杂,而非完全天真。

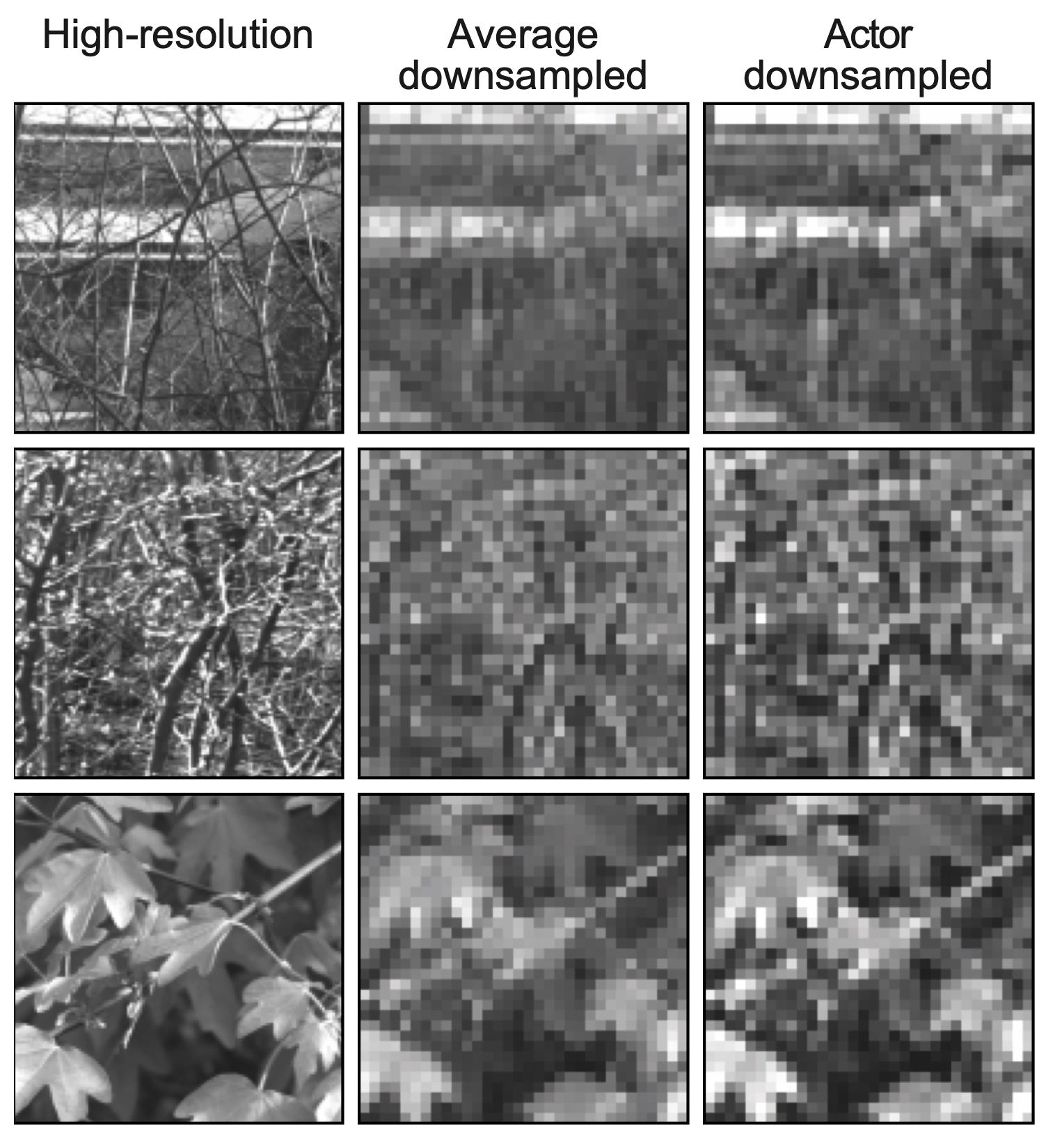

神经编码在假体视觉中正在被证明是非常有用的,瑞士EPFL的研究人员发现。人工视网膜和其他替代人类视觉系统部分的方法通常由于微电极阵列的限制而具有非常有限的分辨率。因此,无论传入的图像有多么详细,都必须以非常低的保真度进行传输。但是有不同的降采样方式,这个团队发现机器学习在这方面做得非常好。

迭戈·盖齐在一份新闻稿中表示:“我们发现,如果采用基于学习的方法,我们在优化感觉编码方面取得了改进的结果。但更令人惊讶的是,当我们使用无约束的神经网络时,它自行学会了模仿视网膜处理的某些方面。”它基本上进行了感知压缩。他们在老鼠视网膜上进行了测试,所以这并不只是理论。

斯坦福研究人员对计算机视觉的一项有趣应用揭示了儿童如何发展绘画技能的谜团。该团队征集并分析了37,000幅儿童绘制的各种物体和动物的图画,还根据儿童的回答研究了每幅作品的可识别程度。有趣的是,并不仅仅是兔子的耳朵等标志性特征的包含让其他儿童更容易识别这些图画。

首席研究员朱迪思·范表示:“从年长孩子的画作中能够被识别的特征种类,并不是所有大孩子都学会在他们的画作中包含的单一特征所推动的。这是一种更加复杂的东西,这些机器学习系统正在捕捉到。”

化学家们(也包括EPFL)发现LLM在经过最少培训之后,也能意外地擅长帮助他们的工作。这不仅仅是直接从事化学领域,而是对化学家们个别无法完全了解的大量工作进行微调。例如,在成千上万篇论文中可能会有几百个关于高熵合金是单相还是多相的陈述(您不必知道这意味着什么-他们知道)。该系统(基于GPT-3)可以接受此类是/否问题和回答的训练,并很快能够推断出更多信息。

这并不是什么巨大的进展,只是更多证据表明LLMs在这方面是一个有用的工具。研究员Berend Smit说:“关键是这就像进行文献检索那样简单,这对许多化学问题都适用。查询一个基础模型可能会成为启动项目的常规方式。”

最后,来自伯克利研究人员的一句警告,尽管现在我再次阅读这篇文章时发现洛桑联邦理工学院也参与其中。加油,洛桑!该团队发现,通过谷歌搜索到的图像比提及相同内容的文字更容易强化某些职业和词语的性别刻板印象。而且在这两种情况下男性的出现数量也明显更多。

不仅如此,在一项实验中,他们发现研究某种角色时,浏览图像而不是阅读文本的人更可靠地将这些角色与一个性别相关联,甚至几天后仍然如此。研究人员道格拉斯·吉尔博在谈到这一点时表示:“这不仅仅是关于在线性别偏见的频率。这个故事的一部分是,图像对人物的代表性有一种非常粘性,非常强大,而文本则没有。”

随着谷歌图像生成器多样性事件的发生,很容易忽视一个被频繁验证的事实:许多人工智能模型的数据源存在严重偏见,而这种偏见对人们有实质影响。