大型语言模型可以帮助家用机器人在没有人类帮助的情况下恢复错误

家用机器人在Roomba之后很少取得成功,原因无数。定价、实用性、外形以及地图绘制等都导致了一次又一次的失败。即使这些问题得到解决,还是有一个问题,就是当系统犯下必然的错误时会发生什么。

在工业领域,这也是一个摩擦点,但大公司有资源来解决问题。然而,我们不能期望消费者在问题出现时学习编程或者雇佣有帮助的人。幸运的是,这是大型语言模型(LLMs)在机器人领域的一个很好的应用案例,正如麻省理工学院的新研究所展示的那样。

一项将在五月份举行的国际学习表征会议(ICLR)上展示的研究声称将一些"常识"引入到纠正错误的过程中。

学校解释说:“事实证明,机器人是出色的模仿者。但除非工程师们还给它们编程,让它们能够适应各种可能的颠簸和轻碰,不然机器人可能不知道如何处理这些情况,除非重新从头开始执行任务。”

传统上,当机器人遇到问题时,它会在需要人类干预之前耗尽预先编程的选项。这在像家庭这样一个结构不完善的环境中尤其具有挑战性,因为任何改变都可能对机器人的功能产生不利影响。

研究人员指出,尽管在家用机器人领域,通过观察学习(模仿学习)很受欢迎,但通常无法考虑到许多小的环境变化,这些变化可能会干扰正常操作,因此需要系统重新从头开始。这项新研究在一定程度上通过将示范分解为更小的子集来解决这个问题,而不是将它们视为连续动作的一部分。

这就是LLMs发挥作用的地方,消除了程序员手动标记和分配众多子操作的要求。

研究生王彤轩表示:“LLMs可以用自然语言告诉你如何执行任务的每一个步骤。人类的持续演示是这些步骤在物理空间中的具体体现。我们希望将这两者连接起来,让机器人能自动知道任务的进行阶段,并能够自行重新规划和恢复。”

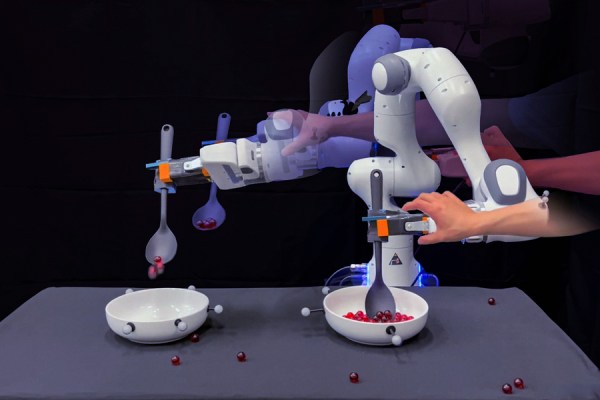

该研究的特定示范涉及训练机器人捞取弹珠并倒入空碗中。对人类来说,这是一个简单且可重复的任务,但对机器人来说,这是各种小任务的结合。LLMs能够列出和标记这些子任务。在示范中,研究人员会以小小的方式破坏活动,如让机器人偏离轨道或把弹珠从勺子上弄掉。该系统通过自我修正这些小任务而不是从头开始来应对。

王补充道:“通过我们的方法,当机器人犯错时,我们不需要让人类进行编程或提供额外的示范来从失败中恢复。”

这是一种有效的方法,可以帮助人避免彻底失去理智。