本周AI热点:AI伦理似乎越来越被忽视

跟上如此快速发展的人工智能行业需求很高。因此,在一个人工智能可以替代你之前,以下是人工智能领域的最新新闻、重要研究和实验的便捷汇总,这些内容我们之前没有单独报道。

本周在人工智能领域,新闻周期终于(终于!)在假期前略为平静下来。但这并不意味着没有写作的素材,对于这位睡眠不足的记者来说,这既是一种福音也是一种诅咒。

今早,美联社的一则标题引起了我的注意:“人工智能图像生成器正在接受儿童淫秽照片的培训。” 故事的要点是,LAION 是一个用于训练许多流行的开源和商业人工智能图像生成器的数据集,其中包含了数千张涉嫌儿童性虐待的图片。斯坦福的斯坦福互联网观察组织与反虐待慈善机构合作,找出了这些非法材料,并向执法机构报告了相关链接。

现在,非营利组织LAION已经撤下了其训练数据,并承诺在重新发布之前删除有问题的材料。但这一事件凸显出在竞争压力不断增加的情况下,生成式人工智能产品中缺乏思考的程度有多么少。

由于无代码人工智能模型创作工具的普及,如今训练生成式人工智能模型变得非常容易,可以应用到任何可能的数据集上。这对于初创企业和科技巨头来说都是一大福音,因为可以更快地推出这样的模型。然而,随着准入门槛的降低,也带来了不择手段地抛弃伦理道德,追求市场快速推广的诱惑。

道德是困难的 - 这是无可否认的。就拿LAION中数以千计的问题图像来说,要彻底整理并不是一夜之间就能实现的。而且最理想的是,在道德上开发人工智能需要与所有相关利益相关者合作,包括代表经常被边缘化和不利影响的群体的组织。

这个行业充斥着以股东而非伦理学家的决策为导向的人工智能发布例子。以必应聊天(现在是微软的Copilot)为例,微软在推出时的人工智能聊天机器人曾将一位记者比作希特勒并侮辱其外貌。截至十月,谷歌的ChatGPT竞争对手ChatGPT和Bard仍然提供过时而种族主义的医疗建议。而最新版OpenAI的图像生成器DALL-E显示出显著的英美中心主义偏见。

可以说,在追求人工智能的优势方面会造成伤害-或者至少是华尔街对人工智能优势的理解。也许随着欧盟人工智能法规的通过,对于不遵守特定人工智能准则的行为将会受到罚款的威胁,可能有一些希望在前方的地平线上。但前方的道路确实漫长。

以下是近期几天其他一些值得关注的人工智能故事:

2024年人工智能的预测:Devin详细阐述了他对2024年人工智能的预测,提及了人工智能可能如何影响美国初选和开放AI的未来等话题。

抵制伪人类化:德文还提议禁止人工智能模仿人类行为。

微软Copilot开始进行音乐创作: 微软的AI聊天机器人Copilot现在可以通过与GenAI音乐应用Suno的整合来创作歌曲。

莱特爱德禁止使用人脸识别技术:联邦贸易委员会发现,美国药店巨头莱特爱德“草率地使用人脸监控系统”导致顾客羞辱,并使其“敏感信息面临风险”,因此禁止其在未来五年内使用人脸识别技术。

欧盟提供计算资源:欧盟正在扩大其原计划,该计划最早于九月份宣布并在上个月启动,旨在通过向本土人工智能初创企业提供使用欧盟超级计算机进行模型训练的处理能力来支持它们。

OpenAI赋予董事会新的权力:OpenAI正在扩展其内部安全流程,以应对有害人工智能的威胁。一个新的“安全咨询小组”将位于技术团队之上,向领导层提供建议,并且董事会获得了否决权。

UC伯克利的肯·戈德堡教授接受了布莱恩的邀请,进行了一次问答活动。布莱恩是一位创业者和成功的机器人专家,他与肯·戈德堡就人形机器人和机器人行业的更广泛趋势进行了讨论。

首席信息官在推广人工智能技术方面采取谨慎态度:罗恩指出,虽然首席信息官们面临着推出ChatGPT在线玩耍所带来的各种体验压力,但大多数人在引入该技术到企业中时采取着谨慎和审慎的态度。

新闻出版商起诉谷歌AI:数家新闻出版商提起了一项集体诉讼,指控谷歌通过反竞争手段,特别是利用谷歌的搜索生成体验(SGE)和巴德聊天机器人等人工智能技术“私吞”新闻内容。

OpenAI与Axel Springer达成了协议:提到出版商,OpenAI与总部位于柏林的Axel Springer达成了协议。Axel Springer是拥有Business Insider和Politico等出版物的所有者,OpenAI将使用该出版商的内容来训练其生成式AI模型,并将最新发布的Axel Springer文章添加到ChatGPT中。

谷歌将Gemini带入更多场景:谷歌将其Gemini模型与更多产品和服务相结合,包括其Vertex AI托管的AI开发平台和AI Studio(该公司用于创建基于AI的聊天机器人和其他相关体验的工具)。

更多的机器学习

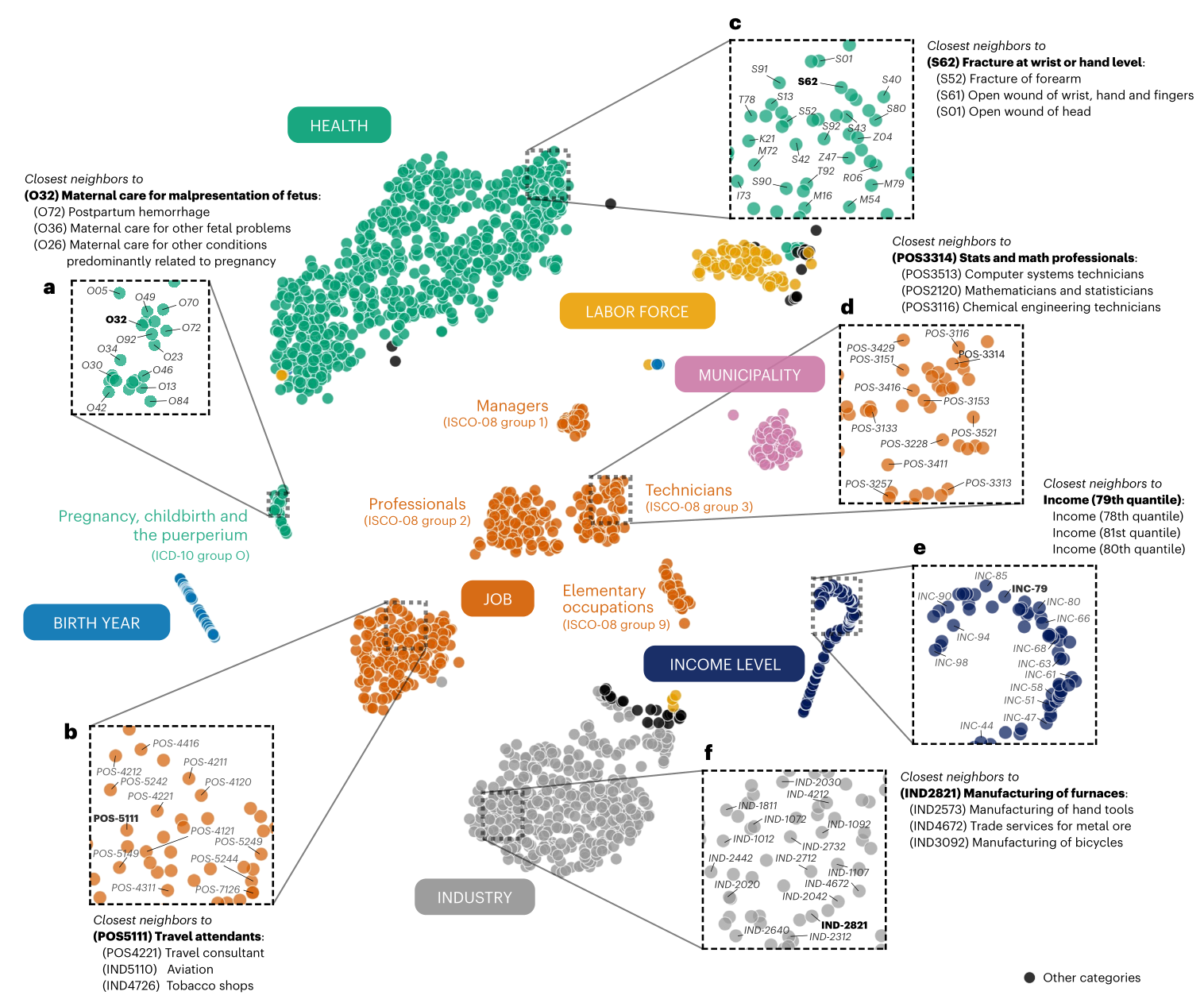

毫无疑问,最近一两周最疯狂(同时也最容易被误解)的研究肯定是来自丹麦的"life2vec"。这项研究利用人生中无数的数据点来预测一个人的性格和寿命。但仅在大致上能够做出预测!

这项研究并不声称能做到神谕的准确性(顺便说一下,再随便念三遍),而是打算通过使用当前的机器学习技术部分地展示出,如果我们的生活是我们经历的总和,那么这些经历的路径可以被外推出来。在成长、教育、工作、健康、爱好和其他指标之间,我们可以合理地预测不仅某人是否内向或外向,还有这些因素可能如何影响预期寿命。我们还没达到“先知罪案”(precrime)的程度,但可以肯定的是保险公司迫不及待地想要获得该项研究的许可。

卡内基梅隆大学的科学家们提出了另一个重要观点,他们研发了一种名为Coscientist的系统,这是一种基于LLM的研究助手,能够自主地完成许多实验室琐事。目前,它仅限于特定领域的化学研究,但就像科学家一样,这些模型也将成为专业人士。

首席研究员加布·戈梅斯告诉《自然》杂志:“当我看到一种非有机智能能够自主地规划、设计和执行一种由人类发明的化学反应时,那真是太神奇了。这是一个‘天呐’的时刻。”基本上,它使用了类似于GPT-4的LLM,通过在化学文件上进行精细调整,来识别常见的反应、试剂和程序并执行它们。所以你不需要告诉实验室技术人员合成四批某种催化剂-人工智能可以做到,而且你甚至不需要顾及它。

谷歌的人工智能研究人员也度过了一个重要的一周,涉猎了几个有趣的前沿领域。FunSearch听起来像是专为儿童设计的谷歌,实际上它是函数搜索的简称,和Coscientist一样,可以进行数学发现并帮助数学发现。有趣的是,为了防止产生幻觉,这个系统(和最近的其他系统一样)使用了一对匹配的人工智能模型,类似于“旧版”GAN结构。其中一个模型进行理论推断,另一个模型进行评估。

尽管FunSearch不会做出任何突破性的新发现,但它可以将现有的东西进行改进或在新的领域重新应用,因此一个领域使用的功能,而另一个领域不知道,可以被用来改进行业标准算法。

StyleDrop是一个方便的工具,适用于想要通过生成图像来复制特定风格的人。研究人员认为存在一个问题,就是如果你有一个想法中的风格(比如“粉色调”),并进行描述,模型将有太多“粉色调”的亚风格可供选择,导致结果是不可预测的。StyleDrop允许你提供一个你想到的风格的示例,模型将基于此展开工作,从而实现了高效的微调。

这篇博文和论文表明它非常稳健,能够将任何图像样式应用到其他类型的图像上,无论是照片、绘画、城市风景还是猫的肖像,甚至包括字母(因为某种原因它对一些人来说非常困难)。

谷歌也在生成视频游戏领域迈进,推出了名为VideoPoet的产品。它使用了一个LLM基础(和现如今的其他东西一样...你还能用什么?)来处理各种视频任务,例如将文本或图像转换为视频,扩展或美化现有视频等等。挑战在于,就像每个项目都明确指出的那样,不仅要制作一系列相互关联的图像,还要使它们在较长时间(比如超过一秒)内保持连贯性,并且拥有大幅度的运动和变化。

视频诗人似乎在推动事物向前发展,尽管如你所见,结果仍然相当奇怪。但这就是事物的进展方式:起初是不足的,然后变得奇怪,而后又变得神秘。可能它们最终会不再神秘,但目前还没有人真正达到那一点。

在实践方面,瑞士的研究人员开始将人工智能模型应用于雪量的测量。通常情况下,我们依靠气象站进行测量,但是这些站点之间可能相隔甚远,而我们却拥有大量可爱的卫星数据,对吗?没错。因此,ETHZ团队采用了来自Sentinel-2星座的公共卫星图像,但正如负责人康拉德·辛德勒所说:“仅仅通过观察卫星图像上的白色区域并不能立即告诉我们雪的深度。”

所以他们从他们的联邦地形办公室(类似于我们的美国地质调查局)获取了整个国家的地形数据,并通过对图像中的白色区域以及地面实况数据和融化模式等趋势进行训练来估计。由此产生的技术正在由ExoLabs商业化,我即将联系他们以了解更多信息。

然而,斯坦福大学发出了一项警告 - 尽管上述应用程序强大,但请注意它们并未包含太多人类偏见。当涉及到健康问题时,这会突然变成一个大问题,而医疗是许多人工智能工具正在接受测试的领域。斯坦福研究人员证明了人工智能模型传播了“旧的医疗种族模式”。GPT-4不能确定事物的真实性,因此它会模仿关于某些群体的旧的、已被证明错误的说法,例如黑人肺活量较低。不对!如果你在医疗和医学领域与任何形式的人工智能模型合作,请保持警惕。

最后,这是一个由巴德创作的短篇故事,附有拍摄脚本和提示,由视频诗人呈现。小心,皮克斯!