AI领域的女性:Anika Collier Navaroli正在努力改变权力不平衡的局面

为了给以人工智能为重点的女性学者和其他人应有的、而且迟到的机会成就光芒,TechCrunch推出了一系列采访,专注于为人工智能革命做出贡献的杰出女性。

Anika Collier Navaroli 是哥伦比亚大学数字新闻托中心的高级研究员,也是 OpEd 项目与麦克阿瑟基金会合作举办的科技公共之声研究员。

她因其在科技领域的研究和倡导工作而闻名。此前,她曾在斯坦福大学慈善与公民社会中心担任种族和科技实践研究员。在此之前,她曾在Twitch和Twitter负责信任与安全工作。Navaroli可能最为人所知的是她在国会作证有关Twitter的言论,她谈到了社交媒体上被忽视的关于即将发生的暴力警告,这是一月六日国会大厦袭击的前兆。

简单来说,你是怎么开始涉足人工智能领域的?是什么吸引你进入这个领域的?

大约20年前,我在家乡报社新闻编辑部当文员,那时报社开始数字化。当时我是一名新闻学本科生。像Facebook这样的社交媒体网站席卷了我的校园,我开始着迷于探究基于印刷机构建的法律会如何随着新技术的出现而演变。这种好奇心让我进入了法学院,在那里我逐渐转向了Twitter,研究了媒体法律和政策,目睹了阿拉伯之春和占领华尔街运动的发展。我把这一切整合在一起,写了我的硕士论文,探讨了新技术如何改变信息传播的方式,以及社会如何行使言论自由。

我毕业后曾在几家律师事务所工作,然后找到了我的去向-数据与社会研究所,领导这个新智囊团对当时所谓的“大数据”、民权和公平进行研究。我的工作重点是研究早期的人工智能系统,如人脸识别软件、预测性执法工具和刑事司法风险评估算法是如何复制偏见和产生意想不到的后果,影响到边缘化社区。然后我去了Color of Change,领导对一家科技公司进行民权审计,制定了组织的科技问责运动手册,并向政府和监管机构倡导科技政策变革。之后,我成为了Twitter和Twitch的信任与安全团队的高级政策官员。

在人工智能领域,你最自豪的工作是什么?

我最自豪的工作是在科技公司内使用政策来实际改变权力平衡,纠正文化和知识生成算法系统中的偏见。在推特,我发起了一些运动,验证了一些令人震惊的之前被排除在独家验证过程之外的个人,包括黑人女性、有色人种和酷儿。这还包括领先的AI学者,如Safiya Noble、Alondra Nelson、Timnit Gebru和Meredith Broussard。这是在2020年,当时的Twitter还是Twitter。那时,验证意味着你的名字和内容成为Twitter核心算法的一部分,因为来自经过验证的账户的推文被注入到推荐、搜索结果、主页时间线中,并有助于创造趋势。因此,努力验证具有不同AI视角的新人,从根本上改变了哪些声音被赋予权威作为思想领袖,推动了新想法在公众对话中的出现,在一些非常关键的时刻。

我对我在斯坦福进行的研究感到非常自豪,这个研究最终成为了《黑人在适度中的地位》。当我在科技公司工作时,我也注意到没有人真正在讨论我作为一名黑人在信任与安全领域工作时每天所经历的经历。因此,当我离开这个行业回到学术界,我决定与黑人科技工作者交谈,揭示他们的故事。这项研究最终成为了其类别的第一项,并引发了许多关于科技员工身份边缘化经历的新而重要的讨论。

你如何在男性主导的科技行业,以及男性主导的人工智能行业中应对挑战?

作为一名黑人酷儿女性,穿越男性主导的领域和我被异化的空间一直是我整个人生之旅的一部分。在科技和人工智能领域,我认为最具挑战性的方面是我在研究中称之为“被迫的身份劳动”。我创造了这个词来描述经常发生的情况,即拥有边缘化身份的员工被视为整个拥有相同身份的社群的代表或发言人。

由于开发人工智能等新技术所带来的高风险,从事这项工作有时会感觉难以逃脱。我必须学会为自己设定非常具体的界限,明确自己愿意处理的问题和时间。

随着人工智能的发展,面临的一些最紧迫的问题是什么?

根据调查报道,目前的生成式人工智能模型已经吞噬了互联网上的所有数据,并且很快将耗尽可用的数据来源。因此,全球最大的人工智能公司正在转向合成数据,即由人工智能自身生成的信息,而不是人类,来继续训练其系统。

这个想法让我陷入了一个兔子洞。最近,我写了一篇观点文章,认为我认为使用合成数据作为训练数据是新人工智能发展面临的最紧迫的伦理问题之一。生成式人工智能系统已经显示,基于它们的原始训练数据,它们的输出是复制偏见并创造虚假信息。因此,用合成数据训练新系统的路径意味着不断地将有偏见和不准确的输出反馈到系统中作为新的训练数据。我把这描述为潜在地演变成一个通往地狱的反馈循环。

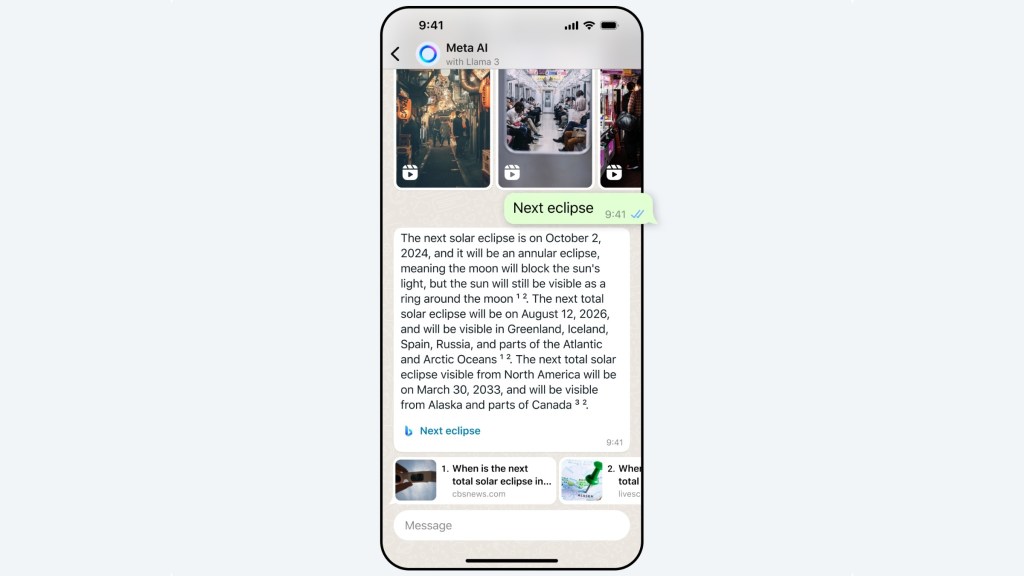

自从我撰写了这篇文章,马克·扎克伯格赞扬Meta更新的Llama 3聊天机器人部分地由合成数据提供动力,并且是市场上“最智能”的生成式AI产品。

AI用户应该注意什么问题?

人工智能在我们当下的生活中是如此无处不在,从拼写检查和社交媒体信息流到聊天机器人和图像生成器。在许多方面,社会已成为这种新的、未经验证的技术实验的小白鼠。但人工智能用户不应感到无助。

我一直在主张科技倡导者应该团结起来,组织人工智能用户呼吁暂停人工智能技术的发展。我认为,美国编剧工会已经证明了,通过组织、集体行动和耐心的决心,人们可以团结起来为人工智能技术的使用制定有意义的边界。 我也相信,如果我们现在暂停下来,纠正过去的错误,制定新的伦理准则和监管,人工智能就不必成为我们未来的生存威胁。

负责任地构建人工智能的最佳方式是什么?

在科技公司工作的经历让我明白,谁在屋里编写政策、提出论点和做决定有多么重要。我的经历还告诉我,通过在新闻学院开始,我获得了在科技行业成功所需的技能。我现在又回到哥伦比亚新闻学院工作,我对培养下一代人感兴趣,他们将在科技公司内部和外部监管者的身份负责科技问责和负责任地开发人工智能。

我认为新闻学院能够为学生提供独特的训练,教会他们怎样审视信息、寻求真相、考虑多方观点、建立逻辑论证,以及从观点和错误信息中提炼事实和真实情况。我相信这是培养将来负责制定下一代人工智能能够做什么和不能做什么规则的人的坚实基础。我期待着为接班人打造更加通畅的道路。

我也相信除了技术娴熟的信任与安全工作者外,人工智能行业需要外部监管。在美国,我认为应该建立一个新的机构来监管美国科技公司,有权制定和执行基本的安全和隐私标准。我还希望继续努力,帮助现任和未来的监管者与前科技工作者联系,他们可以帮助掌权者提出正确的问题并创造新的细致实用的解决方案。