英伟达的新工具允许你在个人电脑上运行GenAI模型

Nvidia为了鼓励人们购买最新的GPU,推出了一款工具,使GeForce RTX 30系列和40系列显卡的用户能够在Windows个人电脑上离线运行一款基于人工智能的聊天机器人。

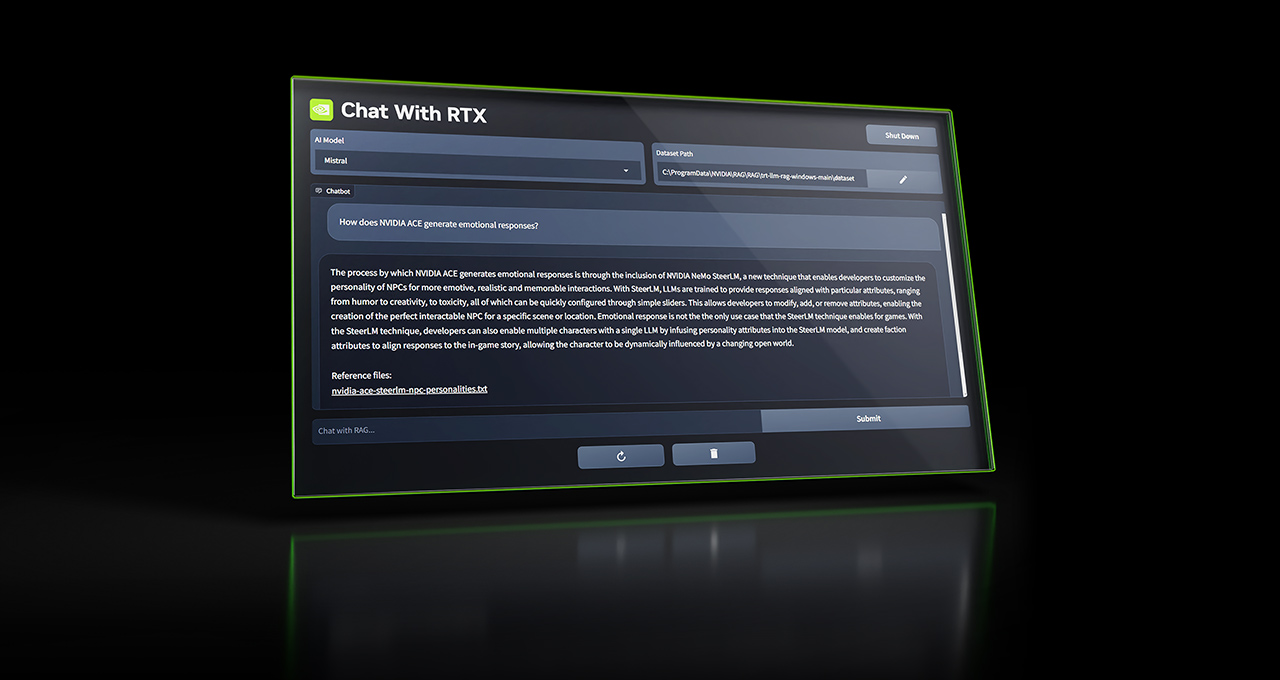

名为与RTX聊天的工具允许用户根据OpenAI的ChatGPT的模式进行自定义,并通过与其连接到文档、文件和笔记进行查询。

在一篇博客文章中,Nvidia写道:“用户不再需要查找笔记或保存的内容,只需简单地输入查询即可。”“例如,用户可以询问‘在拉斯维加斯时,我的伴侣推荐的那家餐厅是哪家?’,而Chat with RTX将扫描用户指定的本地文件,并提供带有背景信息的答案。”

与RTX默认聊天使用的是AI初创公司Mistral的开源模型,但也支持其他基于文本的模型,包括Meta的Llama 2。Nvidia警告说,下载所有必要的文件将占用相当大的存储空间,根据所选择的模型,大约为50GB至100GB。

目前,与RTX的聊天支持文本、PDF、.doc、.docx和.xml格式。将应用程序指向包含任何支持文件的文件夹将加载这些文件到模型的微调数据集中。此外,与RTX的聊天可以接受YouTube播放列表的URL,以加载播放列表中视频的转录,使所选择的模型能够查询其内容。

现在,需要记住一些限制条件,Nvidia的一份指南中详述了这些限制条件,并且要赞扬一下他们。

与RTX聊天时,它无法记住上下文,这意味着当回答后续问题时,该应用不会考虑任何先前的问题。例如,如果你问“北美洲常见的鸟是什么?”然后追问“它的颜色是什么?”,Chat with RTX不会知道你在谈论鸟类。

英伟达还承认,该应用的回答的相关性可能会受到一系列因素的影响,其中一些很容易控制,而另一些则不容易控制——包括问题措辞、所选模型的性能和微调数据集的大小。要求提供几份文件中包含的事实可能会比要求提供文件或一组文件摘要获得更好的结果。英伟达表示,随着数据集的增大,回答质量通常会提高——随着将RTX聊天引导到更多关于特定主题的内容,回答质量也将提高。

所以与RTX聊天更像是一种玩具,不太适合在生产中使用。然而,可以说这种能够更轻松地在本地运行人工智能模型的应用程序有其可取之处 - 这是一种不断增长的趋势。

在最近的一份报告中,世界经济论坛预测了可以离线运行GenAI模型的价格合理的设备(包括个人电脑、智能手机、物联网设备和网络设备)将会出现“戏剧性”的增长。WEF表示,原因是明显的好处:离线模型不仅本质上更加私密——它们处理的数据永远不会离开运行的设备,而且它们的延迟更低、更具成本效益,超过了云端模型。

当然,将运行和训练模型的工具民主化会向恶意行为者打开大门——仅仅进行一次谷歌搜索就会出现许多以不良网站为来源的带有有毒内容的优化模型。但是,像RTX即时聊天这样的应用的支持者认为好处大于坏处。我们只能等待并观察。