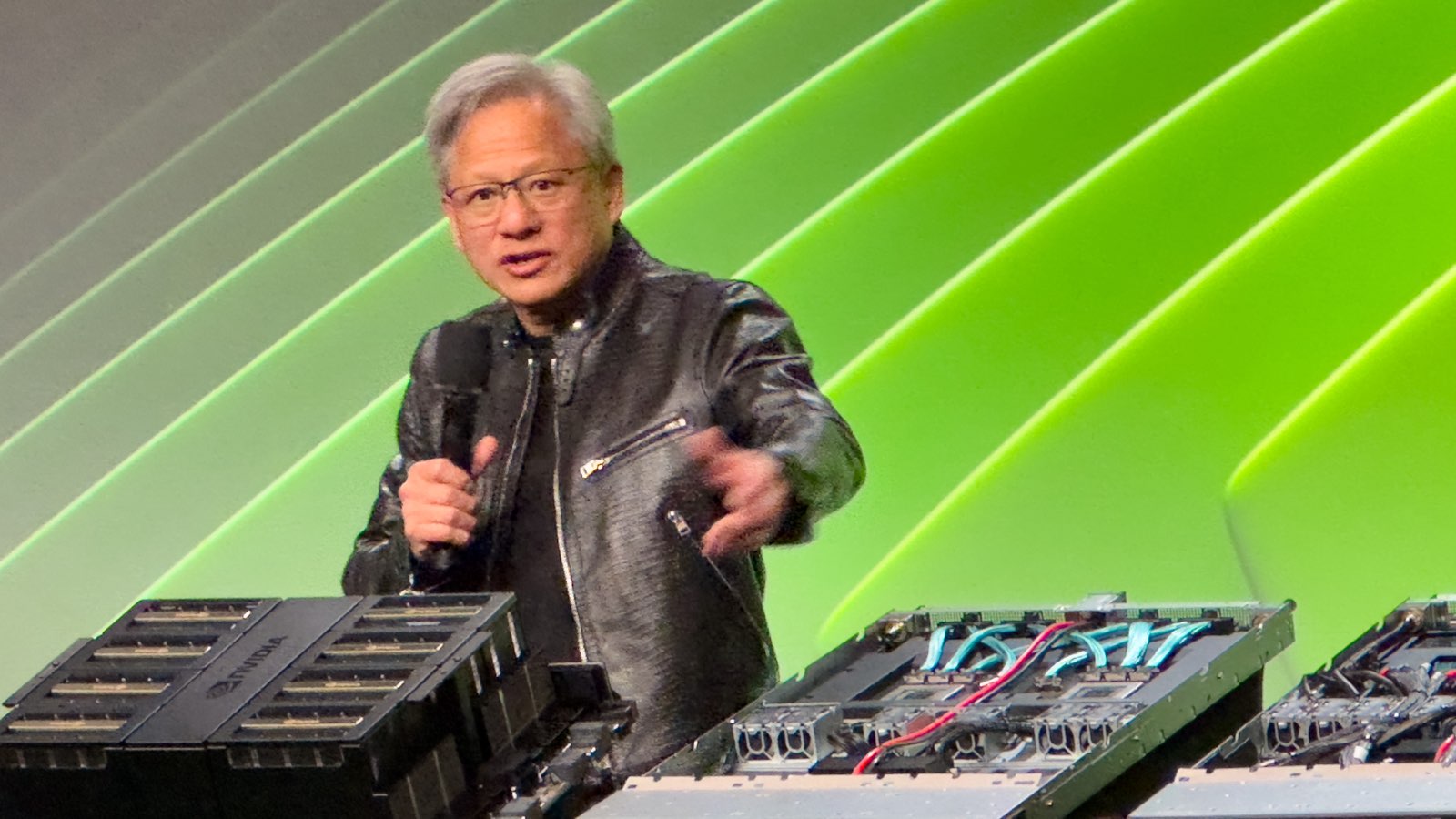

NVIDIA公司的黄仁勋表示,人工智能的幻觉问题是可以解决的,人工智能普遍智能还有5年才会实现

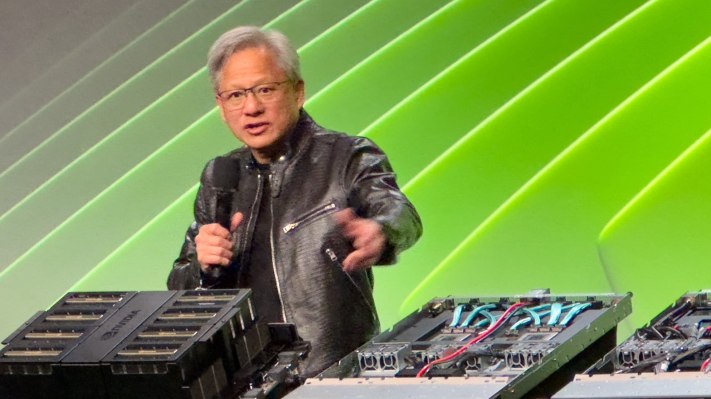

人工通用智能(AGI)——通常被称为“强人工智能”,“完全人工智能”,“人类级人工智能”或“通用智能行为”——代表着人工智能领域的重大未来飞跃。与狭义人工智能不同,后者专为特定任务(如检测产品缺陷、总结新闻或为您建立网站)而设计,AGI将能够以人类水平或以上执行广泛的认知任务。在本周在英伟达年度GTC开发者大会上对媒体发表讲话时,CEO黄仁勋似乎对讨论这个主题感到非常无聊——尤其是因为他经常发现自己被误传,他说。

这个问题的频率是有道理的:这个概念引发了关于人类在未来机器能在几乎所有领域都能比人类更聪明、更学习、更强大的角色和控制的存在主义问题。这个担忧的核心在于人工智能的决策过程和目标的不可预测性,这些可能不符合人类的价值观或优先事项(自20世纪40年代以来在科幻小说中深入探讨的概念)。人们担心一旦人工智能达到一定程度的自主性和能力,可能就会变得不可能收纳或控制,导致其行动无法预测或逆转的情况。

当媒体爱卖惊悚的新闻时,常常是要AI专业人士设定一个时间表,用以暗示人类的终结——或者至少是现状结束的时间。可以想而知,AI公司的CEO并不总是急于触及这个议题。

然而,黄先生花了一些时间告诉媒体他对这个话题的看法。黄先生认为,预测我们何时会看到一个令人满意的人工智能取决于您如何定义人工智能,并且画了一些类比:即使有时区的复杂性,你知道新年什么时候到来,2025年就会到来。如果你开车去圣何塞会议中心(今年的GTC会议就在那里举行),当你看到巨大的GTC横幅时,通常你就知道你已经到达了。关键点在于我们能够达成一致,无论是在时间上还是在地理位置上,我们都知道如何衡量你已经到达你希望去的地方。

黄先生解释说:“如果我们将AGI定义为一组测试,一个软件程序可以做得非常出色的测试,或者比大多数人好8%的话,我相信我们将在5年内达到这个目标。” 他建议这些测试可以是法律考试、逻辑测试、经济测试,或者可能是通过预医学考试的能力。除非问询者能够非常明确地解释在问题背景下AGI的含义,否则他不愿意进行预测。说得有道理。

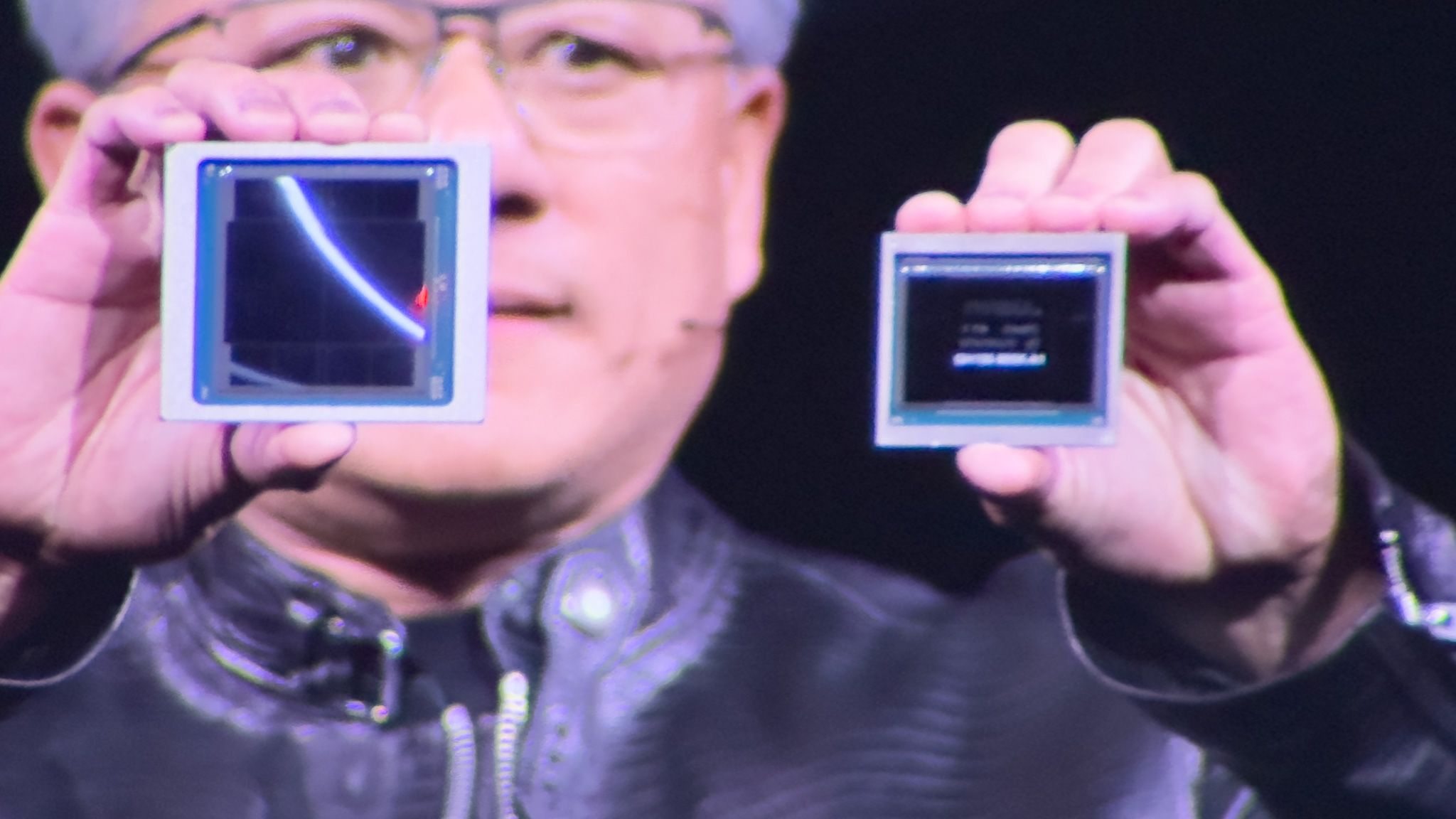

AI幻觉是可以解决的。

在周二的问答环节中,有人问黄先生如何应对人工智能幻觉——一些人工智能往往编造听起来合理但并非事实的答案。他对这个问题显然感到挫败,并建议通过确保答案经过深入研究来轻松解决幻觉问题。

黄指出:“增加一条规则:对于每一个单独的答案,你都必须查证答案。”他将这种做法称为“检索增强生成”,描述了一种非常类似基本媒体素养的方法:审查消息来源和背景。将消息来源中包含的事实与已知真相进行比较,如果答案事实上不准确 - 即使部分不准确 - 应该放弃整个来源,转向下一个。他说:“AI不应该只是回答问题,应该先做研究,确定哪一个答案是最好的。”

对于关键任务的答案,比如健康建议之类的,英伟达的CEO建议或许是查阅多个资源和已知的真实来源才是前进的方法。当然,这意味着生成答案的生成器需要有选择地说出,“我不知道你问题的答案”,或者“我无法得出对这个问题正确答案的共识”,甚至是“嘿,超级碗还没有发生,所以我不知道谁赢了”。